Vous pouvez lire le billet sur le blog La Minute pour plus d'informations sur les RSS !

Canaux

4823 éléments (58 non lus) dans 55 canaux

Dans la presse

(50 non lus)

Dans la presse

(50 non lus)

Du côté des éditeurs

(3 non lus)

Du côté des éditeurs

(3 non lus)

Toile géomatique francophone

(5 non lus)

Toile géomatique francophone

(5 non lus)

Toile géomatique francophone (4 non lus)

Toile géomatique francophone (4 non lus)

-

sur Conférence de Michel Bruneau sur le Cambodge, Institut de Géographie (Paris), samedi 18 janvier 2025

Publié: 6 January 2025, 1:12pm CET par r.a.

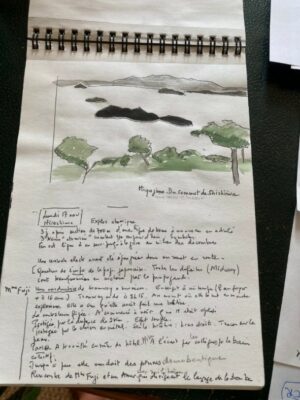

Samedi 18 janvier 2025, de 10h à 12h, à l’Institut de Géographie, 191 rue Saint-Jacques, 75005 Paris, le géographe Michel Bruneau viendra animer une conférence sur le Cambodge.

Dans son ouvrage Parcours d’un géographe de transitions (L’Harmattan, 2023), Michel Bruneau revient sur le chemin qui l’a conduit de la géographie tropicale à la géographie critique. Après sa thèse sur la Thaïlande, il est devenu un éminent spécialiste de l’Asie du Sud-Est qui a proposé notamment un modèle d’organisation de l’espace du Cambodge.

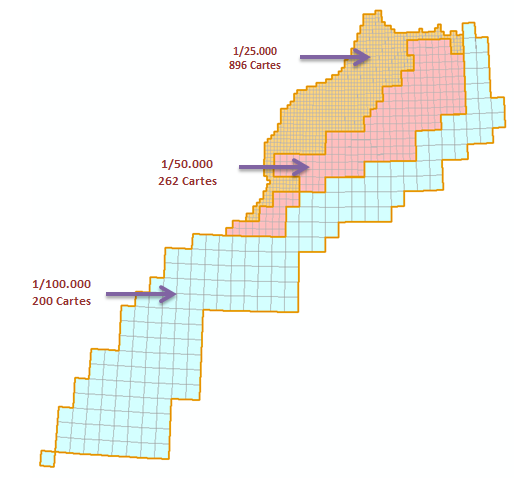

Source : Michel Bruneau, Carte reproduite dans BAGF ( [https:]] )

Au-delà d’une meilleure compréhension de l’organisation de l’espace cambodgien, il faudra se demander si la relation entre les structures territoriales de l’Etat-nation actuel et celles de la période précoloniale est toujours lisible.

A lire sur le site des Cafés Géo : Les Cafés Géo » Michel Bruneau, un « géographe de transitions »

-

sur Géohistoire des humains sur la Terre

Publié: 2 January 2025, 10:31pm CET par r.a.

Café de Flore, Paris, mardi 17 décembre 2024, C. Grataloup et D. Oster (de droite à gauche, photo de M. Huvet-Martinet)

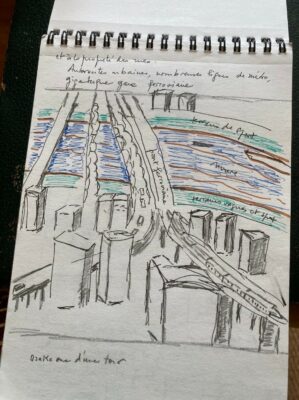

Ce mardi soir, un public nombreux assiste au Café géo dont le sujet porte sur la « géohistoire des humains sur la Terre ». Pour aborder cette question un unique intervenant : Christian Grataloup, le géohistorien bien connu qui incarne largement la réflexion géohistorique depuis de nombreuses années. Auteur d’un livre d’une ambition rare (Géohistoire. Une autre histoire des humains sur la Terre, Les Arènes, 2023), C. Grataloup se propose durant cette soirée d’éclairer ce que l’histoire des sociétés doit à leur espace. Rien que cela !

DO : Ton livre Géohistoire paru l’année dernière marque l’aboutissement d’un long cheminement dans ta réflexion géohistorique. C’est peut-être pour cela que tu as choisi de le titrer sobrement Géohistoire, même si un sous-titre plus explicite l’accompagne : Une autre histoire des humains sur la Terre.

CG : En fait, le titre Géohistoire est un choix éditorial qui montre bien que l’expression créée par Fernand Braudel est tout à fait passée dans le domaine public.

DO : Les médias qui t’ont interviewé n’ont pas manqué de te demander une énième fois ta définition de la géohistoire. Tu réponds souvent qu’il s’agit d’éclairer ce que l’histoire des sociétés doit à leur espace. Dans ce livre tu évoques une synthèse de deux types de relations : les relations entre les sociétés et les relations avec le reste de la biosphère. Peux-tu préciser cet objectif ?

CG : La géohistoire assume sa bâtardise (histoire et géographie). Il faut articuler constamment les logiques d’organisation spatiale avec les processus de temporalité. Il faut tenir compte de tous ces éléments. Certains journalistes aiment dire que je suis le plus historien des géographes. Mais peut-être suis-je le plus géographe des historiens ?

Pour moi, par exemple, un des éléments clés du livre est la distance, c’est-à-dire l’éloignement ou la proximité entre les différentes sociétés, soit un élément géographique fondamental de l’évolution historique. Je parle d’un « singulier pluriel » pour une seule espèce humaine et des sociétés très différentes les unes des autres. L’histoire humaine est prise entre proximité et mobilité. Cette diversité des sociétés est un élément essentiel en même temps que le regroupement, les fusions, les diminutions, par exemple du nombre des langues D’où l’importance à mes yeux de la carte des langues au XVe siècle (17 000 à cette époque contre 6 000 aujourd’hui).

DO : Ton travail consiste à faire de la géohistoire à l’échelle mondiale comme le prouvent les titres de la plupart de tes livres. Mais il est bien sûr possible de faire de la géohistoire à une autre échelle, par exemple nationale ou locale.

CG : C’est vrai qu’aujourd’hui, en France, la géohistoire est rangée dans la catégorie de l’histoire globale. Je pense que la première est particulièrement bien adaptée à la seconde. Mais le problème de distance entre les différents acteurs sociaux est le même à toutes les échelles. Par exemple, c’est ce que j’ai essayé de faire avec l’Atlas historique de la France (Les Arènes-L’Histoire, 2019).

DO : On te questionne souvent sur ton utilisation de l’histoire contrefactuelle qu’on appelle aussi l’histoire des possibles. Peux-tu rappeler ce qu’est ce type d’histoire et pourquoi tu y as recours quelquefois ?

CG : L’uchronie raisonnée est une démarche expérimentale dans un processus temporel, elle aide à la réflexion et notamment permet de relativiser. Par exemple, si le monde avait été tissé par les Polynésiens, le monde aurait été totalement différent de ce qu’il est devenu à partir du XVIe siècle, lorsque les Européens ont influencé considérablement les interrelations entre les sociétés humaines.

DO : Abordons maintenant l’histoire des humains sur la Terre avec la préhistoire, plus précisément le paléolithique, avant donc la révolution néolithique. C’est le moment où l’animal humain sort de la savane arborée pour migrer vers des environnements très divers. Une carte très intéressante représente l’aire de diffusion des homo erectus, elle est titrée très pertinemment « sortir de son écosystème : le propre des humains ». Peux-tu expliquer ce titre ?

CG : Il y a actuellement des discussions à propos de la traduction du titre de l’ouvrage (5 traductions en cours). Les Néerlandais ont choisi de titrer le livre en utilisant l’expression De la savane à la ville. Ceci pour dire que ce qui me semble caractériser l’espèce humaine par rapport à tous les autres primates, c’est son ubiquité : il y a des humains partout. Ce processus a commencé il y a 2 millions d’années quand homo erectus est sorti d’Afrique ; les différentes espèces humaines ont su vivre dans des milieux qui n’étaient pas biologiquement le leur grâce à la maîtrise du feu, à la maîtrise du vêtement, à la construction de logements complexes, donc grâce à leur capacité à produire des micro-milieux. C’est vrai pour Sapiens depuis 300 000 ans.

Ce qui est à l’origine d’une part, de l’unité de l’espèce, et d’autre part, du fractionnement en de multiples sociétés (diversité des langues, des modes de vie, etc.)

DO : Sapiens vit donc dans tous les milieux. On peut parler de diffusion-dispersion avec pour corollaire le fractionnement en sociétés sans contact. A cet endroit du livre, tu cites la controverse de Valladolid et La Planète des singes de l’écrivain Pierre Boulle. Pourquoi cela ?

CG : Selon l’Eglise, ce qui prouvait l’humanité des populations autochtones rencontrées lors des « Grandes Découvertes » c’était l’interfécondité entre ces populations et les Européens. Quant au livre La planète des singes, il montre à sa manière comment le romancier Pierre Boulle s’est emparé de la question d’une commune espèce humaine.

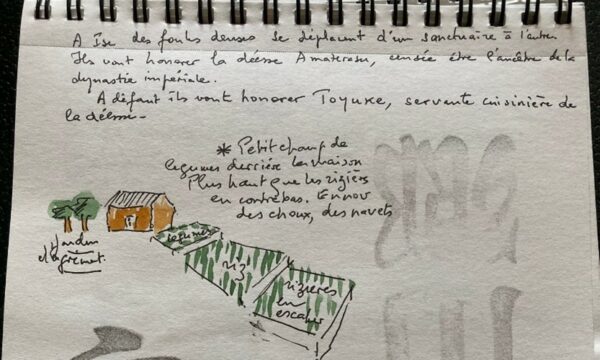

DO : Evoquons maintenant l’avènement du Néolithique qui se caractérise par la domestication du vivant (végétaux et animaux) et la sédentarisation des populations. Au lieu du néolithique tu préfères parler des néolithiques, sans doute à cause de la dispersion des foyers de néolithisation dans le monde. Comment peut-on expliquer la simultanéité relative de cette dispersion ?

CG : Effectivement, les premières domestications sont apparues dans plusieurs foyers très dispersés sur la terre (Proche-Orient, Chine, Asie méridionale, Afrique occidentale, etc.) mais dans une fourchette de temps assez réduite. Pourquoi ces foyers indépendants de domestication ? Une première explication : l’absence de communications avérées. Une autre cause : la très forte coïncidence chronologique a empêché le déploiement d’un processus de diffusion. Il faut donc admettre le polygénisme des sociétés agricoles.

DO : Qu’en est-il des conséquences de la synchronie hétérogène au niveau des domestications (« le lama et la vache ») ?

CG : Les deux grands ensembles géographiques de plantes et d’animaux domestiqués (l’Eufrasie et l’Amérique) diffèrent par les potentialités préalables de domestication. Il semble bien s’agir d’une question d’offre. Le déséquilibre est flagrant dans le domaine animal. L’Amérique ne disposait d’aucun gros mammifère domesticable comme le cheval ou le dromadaire. Cela a eu des conséquences pour l’alimentation, le transport, le travail et même l’art militaire.

DO : Un chapitre passionnant traite des dernières diffusions spatiales, notamment en Amérique et en Océanie. La science archéologique progresse au point de donner aujourd’hui une profondeur historique à des espaces tels que les grandes plaines centrales d’Amérique du Nord et l’Amazonie. Prenons l’exemple de cette dernière qui illustre parfaitement ce qu’on appelle les « peuples sans histoire ». Que sait-on de nos jours de l’histoire de l’Amazonie ?

CG : Des régions entières n’ont entretenu que des liens rares et distendus avec l’axe de l’Ancien Monde. Certaines sociétés ont tout de même été partiellement reliées à cet axe comme celles du littoral de l’est africain. D’autres sociétés étaient entièrement coupées de cet axe comme les sociétés amérindiennes qui ont vécu indépendamment de l’histoire de l’Eufrasie et qui de ce fait ont eu une histoire de pandémies tout à fait particulière.

Grâce aux progrès de l’archéologie, deux grandes régions ont acquis une profondeur historique à peine perçue jusqu’à la seconde moitié du XXe siècle : les grandes plaines centrales d’Amérique septentrionale et l’Amazonie.

DO : La carte « L’Axe de l’Eufrasie au début de notre ère » montre un monde connecté de la Chine à Rome en l’an 200. Depuis le Néolithique, une zone de forte densité humaine (au moins les deux tiers de l’humanité) s’est structurée des mers de Chine à la Méditerranée. Au IIe siècle, elle est organisée autour de grands empires. Ceux-ci font face, au nord, aux peuples des steppes, éleveurs et caravaniers. Plus au sud se trouvent des ensembles plus petits. C’est une « première mondialisation » avec les routes de la soie et celles des épices maritimes. Peux-tu développer ce que tu appelles « l’origine axiale du Monde ».

CG : Depuis plusieurs milliers d’années, entre Chine et Méditerranée, l’axe de l’Ancien Monde regroupe approximativement les trois quarts de l’humanité. Là, les sociétés sont nécessairement interconnectées puisque voisines ; quand une société a une innovation, celle-ci va se répandre chez les autres. Il y a d’ailleurs toutes sortes de passages : des mers littorales, des axes fluviaux, des steppes qui vont être peuplées par des peuples faisant le choix de l’élevage. Se sont donc développées des sociétés très différenciées : au sud, des sociétés « à racines » (des cultivateurs) ; au nord, des sociétés « à pattes » (des pasteurs).

DO : Abordons maintenant « la bifurcation du Monde » avec les « Grandes Découvertes » et l’Europe qui devient le centre du Monde. Pourquoi le succès de l’Europe (des hasards et des envies) ?

CG : La connexion avec les sociétés autres que celles de l’axe de l’Ancien Monde ne pouvait a priori être faite que par une société de l’Ancien Monde. Ensuite pourquoi les Européens ? La situation d’extrême occident de l’Europe pouvait inciter ses sociétés à l’aventure maritime. Madère et les Açores furent les premières îles à sucre des Européens qui n’eurent plus qu’à déplacer vers l’ouest au XVIe siècle le complexe socio-économique de la plantation.

DO : Et si le Sud avait créé le Nord ?

CG : Une petite uchronie radicale. Imaginons un rapport Nord-Sud inversé avec des sociétés tropicales qui auraient eu envie de produits tels que le lait ou la viande produits sur des terres avec hivers. Tout ceci pour dire que la péjoration du Sud n’est pas un phénomène naturel.

DO : Pour terminer, quels sont les principaux aspects géohistoriques du XXe siècle et du début du XXIe siècle ? Peut-on distinguer ceux qui se situent dans la continuité du siècle précédent et ceux qui sont en rupture avec lui ? Il me semble que le tableau de notre monde actuel met en jeu trois données fondamentales : une interdépendance accrue, les fractures profondes entre les sociétés, la gestion indispensable de la planète.

CG : Commençons par une mutation fondamentale : la croissance démographique avec un milliard d’habitants sur la Terre en 1800 et plus de 8 milliards aujourd’hui. Les humains sont devenus une espèce invasive qui détruit la mince pellicule de vie végétale et animale. Rien qu’à cause de cela, toutes les sociétés sont interconnectées. La question centrale c’est comment affronter ensemble, avec des sociétés si différentes, ce problème de gestion de notre unique bien commun qui est cette pellicule de vie. Aujourd’hui, on est à la fois dans une urgence d’agir en commun et de prendre en compte la diversité liée souvent à l’héritage colonial… La réflexion géohistorique traduit la nécessité de comprendre le fractionnement des sociétés et de pouvoir contribuer à essayer de le dépasser.

Un deuxième élément de réponse réside dans les rejeux d’héritages. Dans la diversité des sociétés on a des types de configurations sociales qui se sont construites en position les unes par rapport aux autres. Le planisphère politique est un puzzle, celui des Etats-nations. Parmi les plus grandes pièces du puzzle se trouvent en particulier les Etats héritiers des anciens empires de l’Axe (Chine et Russie). Parmi les plus petites pièces du puzzle, il y a de nombreux supports à des activités qui se jouent de l’international (paradis fiscaux, narcotrafic, etc.). Au total, on a un certain nombre d’éléments qui nous posent d’énormes problèmes pour pouvoir organiser ensemble la gestion de notre Planète.

Questions de la salle :

Q1 : Peut-on imaginer l’évolution du monde si Néandertal l’avait emporté ?

CG : Le Musée de l’homme a organisé récemment une exposition sur Néandertal. Celle-ci montre que Néandertal a changé de statut. Il y a 30 ans on le représentait comme une brute épaisse, contrairement à l’Homo Sapiens, qui lui apparaissant comme un civilisé (en devenir). Cela traduisait une vision du monde, celle qui opposait le sauvage à l’homme civilisé (c’est-à-dire l’Européen). Aujourd’hui, une parfaite inversion oppose Néandertal, le « gentil écolo », à Sapiens « qui recherchait le profit et avait tous les défauts ». En fait, on apprendra peut-être que Sapiens avait quelques avantages (sur les possibilités langagières ?) par rapport à Néandertal. Des processus historiques très différents n’auraient sans doute pas existé si Néandertal l’avait emporté.

Q2 : L’Europe affectée à la fin du Moyen Age par le « précapitalisme » a-t-elle bénéficié de ces conditions pour impulser à son profit la mondialisation amorcée par les « Grandes Découvertes » ?

CG : Là, vous posez la question des configurations sociales internes des sociétés. Ma réflexion géohistorique a fait le choix de s’intéresser avant tout aux logiques externes, c’est-à-dire essentiellement aux interrelations entre les sociétés (connexion, pas connexion, hiérarchie ou égalité dans les connexions, etc.). Ce qui se passe à l’intérieur des sociétés n’a pas été un élément important de ma réflexion mais mon livre donne les éléments de contextualisation qui peuvent permettre ensuite de s’intéresser aux structures internes (chinoises, indiennes, ottomanes, etc.) qui sont des éléments importants.

Q3 : Et si Napoléon n’avait pas vendu la Louisiane ?

CG : La Louisiane est très largement un mythe. Au XVIIIe siècle, la Louisiane française (la Nouvelle-France) forme un vaste espace entre le Saint-Laurent et le delta du Mississipi, peuplé (modestement) de colons, l’essentiel étant constitué de territoires où une poignés de Français et de « coureurs des bois » s’adonnent au commerce avec les nations amérindiennes. La configuration géopolitique principale dans le sud des Grandes Plaines était la Comancheria (l’empire comanche, qu’on peut qualifier d’« empire cavalier »), qui avait une réalité plus importante que la Nouvelle-France des chancelleries. Napoléon qui n’avait pas la maîtrise des mers a préféré vendre la Louisiane qu’il n’avait pas la possibilité de contrôler, ni de développer.

Compte rendu rédigé par Daniel Oster, décembre 2024

-

sur Géopolitique de l’Ouzbékistan dans une Asie centrale très convoitée

Publié: 28 December 2024, 11:58am CET par r.a.

C’est au retour d’un voyage en Ouzbékistan que Maryse Verfaillie retrace le rôle qu’a eu ce pays au cœur de l’Asie pendant plus de deux millénaires d’histoire.

-

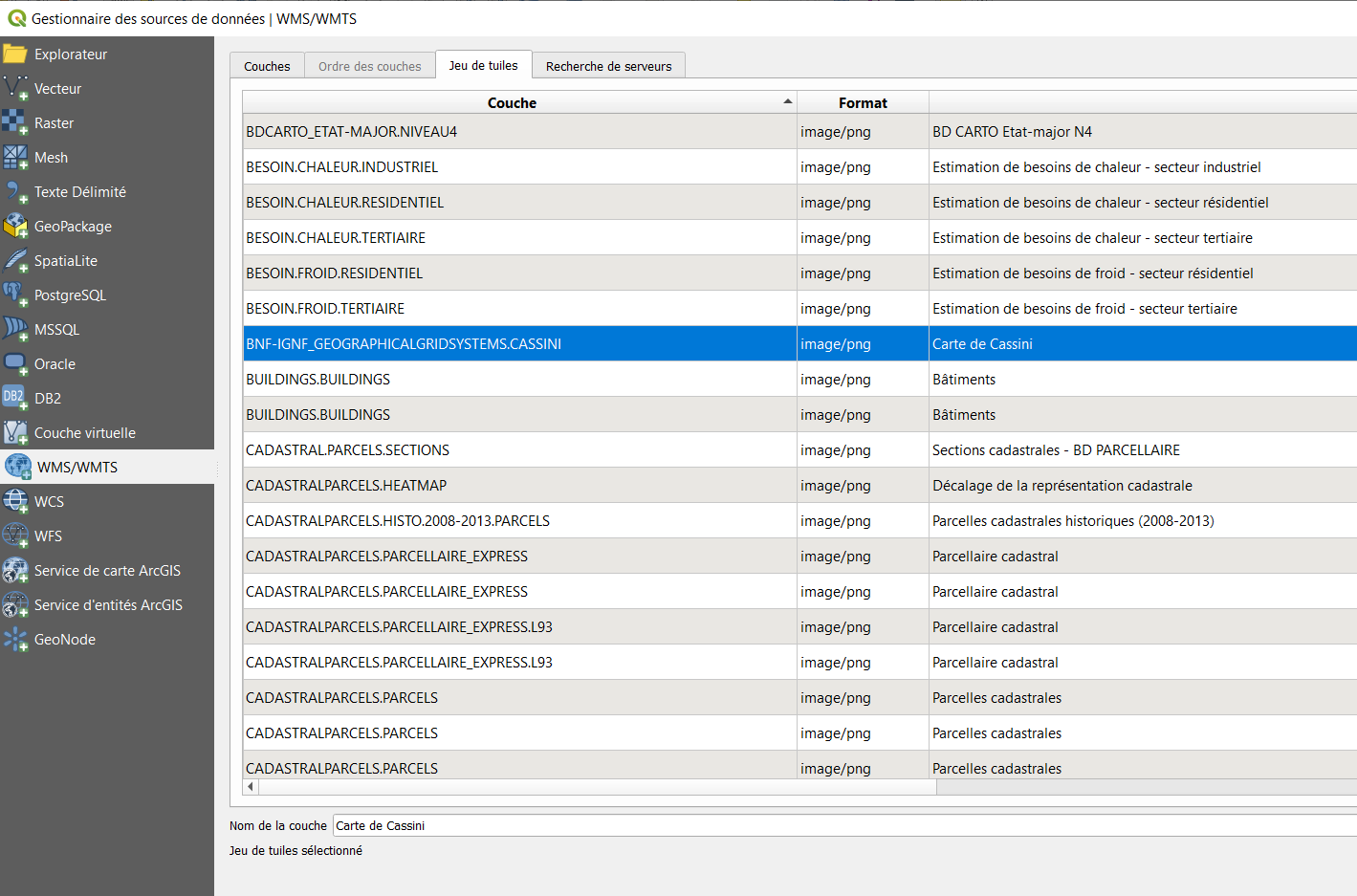

sur LMFP : LE catalogue magique !

Publié: 24 December 2024, 2:00pm CET

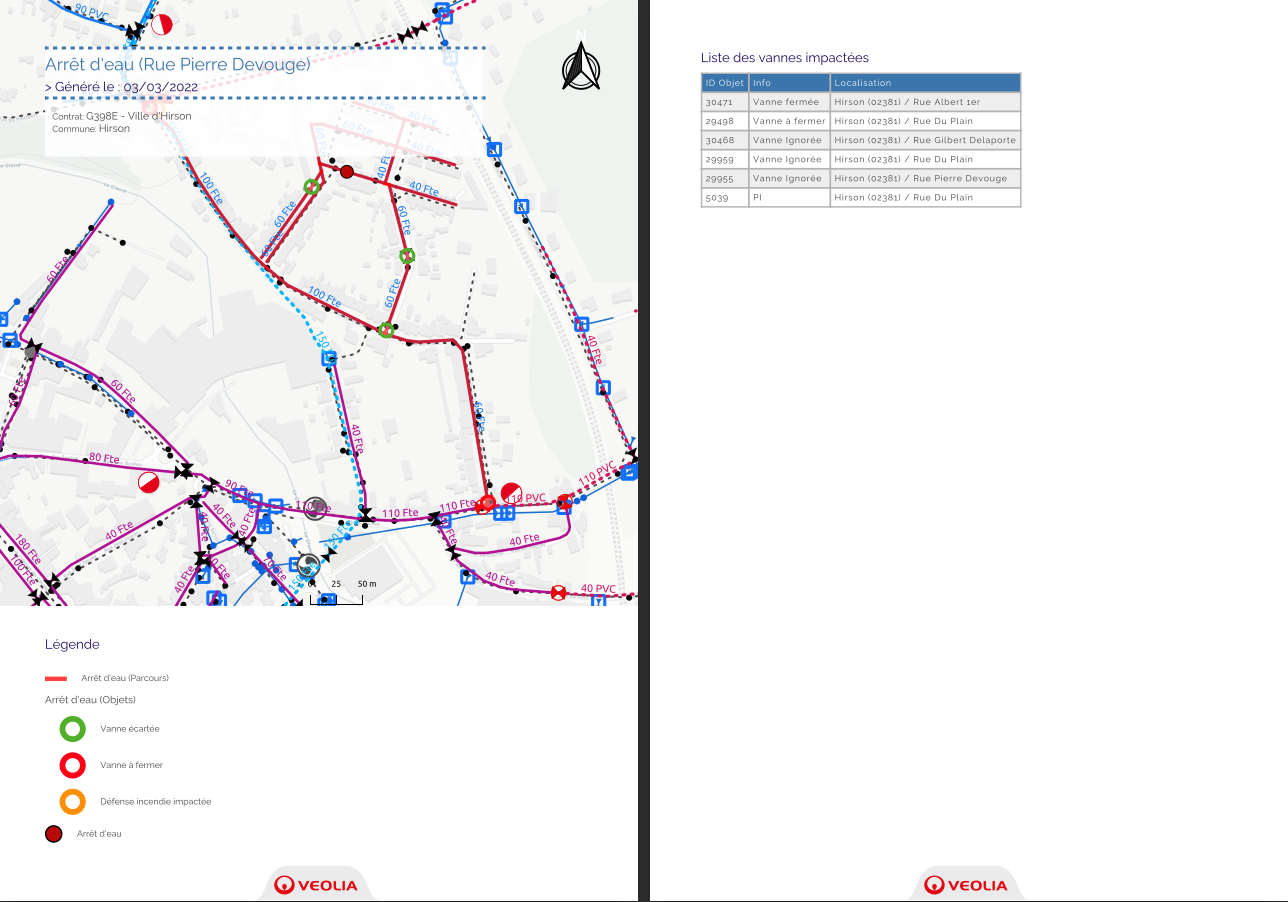

Une extension QGIS peut-être (trop) méconnue : Layers Menu From Project permet de simplifier la vie des administrateurs ET des utilisateurs, retour d'expérience à deux voix.

Une extension QGIS peut-être (trop) méconnue : Layers Menu From Project permet de simplifier la vie des administrateurs ET des utilisateurs, retour d'expérience à deux voix.

-

sur 2024 chez Geomatys

Publié: 23 December 2024, 11:23am CET par Jordan Serviere

2024 chez Geomatys

2024 chez Geomatys

- 23/12/2024

- Jordan Serviere

Alors que 2024 s’achève, Geomatys se distingue une fois de plus comme un acteur clé dans le domaine de l’information géospatiale, des systèmes d’information environnementale et de la défense. Cette année a été marquée par des avancées technologiques concrètes, des reconnaissances importantes et des collaborations stratégiques qui ont renforcé notre position dans des secteurs en constante évolution. Retour sur ces douze mois faits de projets ambitieux et de réalisations collectives.

Examind C2 : réinvention de la gestion tactiqueLe lancement d’Examind C2 représente une étape cruciale en 2024, tant pour Geomatys que pour les secteurs de la défense, de la cybersécurité et de la gestion de crise. Cette plateforme de Commande et Contrôle (C2), conçue pour répondre aux besoins complexes des environnements multi-milieux et multi-champs, se distingue par son interopérabilité avancée et son traitement en quasi-temps réel. Les visualisations dynamiques qu’elle propose offrent une supériorité informationnelle essentielle pour optimiser les prises de décision dans des situations critiques. Avec des capacités étendues en traitement de données spatiales, Examind C2 anticipe également les attentes futures des utilisateurs. Pour une analyse approfondie de ses capacités et de ses cas d’utilisation, rendez-vous sur le site officiel.

AQUALIT : vers une gestion durable de l’eau potableEn 2024, Geomatys a franchi une nouvelle étape avec la commercialisation d’AQUALIT, une plateforme novatrice destinée à l’analyse des mesures d’eau. Conçue spécifiquement pour les producteurs d’eau potable, AQUALIT leur fournit des outils puissants pour surveiller, analyser et optimiser la qualité de leurs ressources. Cette solution intègre des fonctionnalités avancées en gestion des données hydrologiques, en analyse prédictive et en visualisation cartographique. Dans un contexte où la gestion durable de l’eau est devenue un enjeu prioritaire, AQUALIT illustre parfaitement l’engagement de Geomatys en faveur de l’environnement et de l’innovation. Pour en savoir plus et découvrir toutes ses fonctionnalités, consultez le site d’AQUALIT.

OPAT devient ShoreInt : une évolution pour mieux répondre aux besoins côtiersEn 2024, notre projet OPAT a connu une évolution majeure en devenant ShoreInt. Cette transition reflète notre désir d’offrir une solution toujours plus adaptée aux enjeux complexes de la gestion des zones côtières. ShoreInt intègre des données issues de technologies comme l’AIS, les images satellites et la modélisation spatiale pour fournir une analyse précise des activités maritimes et des dynamiques environnementales. Avec une interface ergonomique et des outils avancés de visualisation, ShoreInt est conçu pour aider les décisionnaires à gérer les interactions complexes entre les activités humaines et les écosystèmes côtiers. Pour en savoir plus sur cette solution innovante, consultez le site de ShoreInt.

Lauréat du Concours d’innovation avec EpiwiseUn des temps forts de 2024 est sans conteste la distinction obtenue par Geomatys pour son projet Epiwise lors des Concours d’innovation de l’État. Soutenu par France 2030, ce projet épidémiologique figure parmi les 177 initiatives lauréates reconnues pour leur potentiel à transformer durablement leur secteur. Cette récompense reflète notre capacité à innover tout en répondant à des besoins sociétaux majeurs, tels que la prévention des pandémies et la modélisation épidémiologique. En s’appuyant sur des technologies de machine learning et de traitement des big data, Epiwise offre des perspectives nouvelles pour la santé publique.

Collaboration et continuité : une stratégie collectiveAu-delà de ces projets phares, Geomatys a maintenu en 2024 un rythme soutenu de collaboration dans des initiatives d’envergure. Parmi elles, FairEase, le portail Géosud et nos partenariats stratégiques avec Mercator Ocean et l’Office Français de la Biodiversité. Ces travaux, axés sur la valorisation des données spatiales, l’interopérabilité et la gestion des ressources naturelles, témoignent de notre engagement à développer des solutions ouvertes, accessibles et adaptées aux enjeux environnementaux contemporains. Ces projets, loin de s’arrêter en 2024, constituent un socle solide pour notre développement en 2025 et au-delà.

Et en 2025...Alors que nous nous tournons vers 2025, Geomatys se prépare à renforcer son impact et à ouvrir de nouvelles perspectives. En poursuivant nos investissements dans la recherche et le développement, notamment en télédétection, modélisation environnementale et gestion des données massives, nous ambitionnons de créer des solutions toujours plus performantes et adaptées aux besoins d’un monde en mutation rapide. L’année à venir sera marquée par le renforcement de nos relations avec nos partenaires stratégiques, dans une perspective de collaboration continue et durable. Nous adressons nos sincères remerciements à nos collaborateurs, dont l’engagement et les compétences sont le moteur de nos réussites, ainsi qu’à nos clients et partenaires pour leur soutien indéfectible. Ensemble, faisons de 2025 une année riche en projets et accomplissements. Toute l’équipe vous souhaite de très belles fêtes de fin d’année. Rendez-vous en 2025 !

Menu Linkedin

Twitter

Youtube

Linkedin

Twitter

Youtube

The post 2024 chez Geomatys first appeared on Geomatys.

-

sur Appel à participants - GT Dessertes pour les transports de bois

Publié: 20 December 2024, 11:50am CET

Appel à participants - GT Dessertes pour les transports de bois

-

sur « TERRES ». Dossier spécial FIG 2024 de la revue La Géographie (n°1594, automne 2024)

Publié: 19 December 2024, 7:01pm CET par r.a.

Ce dossier s’intéresse aux « Terres », thème du Festival international de géographie de Saint-Dié en octobre 2024.

Parmi les articles, nous retrouvons ceux d’amis des Cafés géographiques comme Amaury Lorin et Gilles Fumey. Le premier nous avait fait le plaisir de traiter au Café de Flore le sujet évoqué ici, La Birmanie : pivot stratégique entre l’Inde et la Chine, en février dernier ( [https:]] ). Le second alerte sur le vol des terres à leurs premiers habitants dans Terres convoitées, terres accaparées. Le phénomène remonte à l’Antiquité mais prend au XXIe siècle la forme d’un accaparement dû à quelques Etats mais surtout aux firmes de pays riches dans un but financier. En France, seuls quelques vignobles de prestige sont aux mains de sociétés étrangères mais la financiarisation du foncier est défavorable à l’installation des jeunes agriculteurs. Grands acheteurs de terres dans les pays en développement, surtout en Afrique subsaharienne, la Chine et les pays du Golfe invoquent leur souci d’assurer la sécurité alimentaire à leurs populations. En fait beaucoup d’investissements fonciers servent à produire des agrocarburants. Seules des ONG cherchent à lutter contre ces spoliations, parfois avec succès.

François-Michel Le Tourneau explique quels enjeux fonciers se cachent derrière la déforestation de l’Amazonie. Il rappelle d’abord que si la baisse de la déforestation en Amazonie a été notable en 2023 (elle a dépassé 30% par rapport à 2022), ce qui a donné une image positive au gouvernement de Lula, la hausse a été très importante dans les savanes du Centre (« cerrado »). Il s’est donc agi d’un choix essentiellement politique. L’objectif d’une déforestation zéro semble impossible à atteindre car la déforestation peut être légale. Une partie du patrimoine public forestier est devenu privé au profit de ceux qui occupaient ces terres depuis plus de 10 ans. En ont profité les petits propriétaires puis les grands. La délivrance des titres de propriété est néanmoins conditionnée à la mise en valeur des terres, ce qui favorise la déforestation, souvent au profit de l’élevage bovin.

C’est à l’échelle mondiale que Paul Arnould pose la question du statut foncier de la forêt. Ce n’est pas une question marginale car la forêt occupe le tiers des terres émergées. Sur le plan juridique, le bilan est simple : 76% de la terre forestière appartiennent à un Etat, 20% à des propriétaires privés (en général, de grands groupes multinationaux, à l’exception de la France où la propriété est très émiettée), 4% n’ont pas de propriétaires identifiés. Mais en dehors du droit, les situations sur le terrain sont plus complexes. Des droits d’usage anciens sont fortement revendiqués par leurs bénéficiaires, sans être reconnus par la loi. Pour beaucoup de randonneurs contemporains, il va de soi que la forêt est un bien public où tout est permis (cueillette des champignons et des baies etc…). Trois impératifs s’opposent : rationalité économique, situation écologique, réalités sociales. Les situations des terres forestières sont donc très diverses selon les lieux.

Forêts et autres lieux ont été nommés par les hommes qui inscrivent ainsi leur pouvoir dans les paysages. Camille Escudé s’est particulièrement intéressée au « renaming » (pour « changement de nom ») des territoires autochtones. Une des formes du pouvoir colonial a consisté à supprimer les noms donnés par les autochtones aux lieux pour les rebaptiser. Ainsi Chuquiago Marka (« vallée de l’or ») en Amérique du sud est devenue Nuestra Senora de la Paz après la conquête espagnole de 1548. Supprimer aujourd’hui ces noms donnés par le colonisateur fait partie des pratiques de décolonisation et de résistance au pouvoir dominant. Le territoire autonome du Nunavut au Canada, administré par les Inuit, en donne de nombreux exemples. Frobisher Bay (nom d’un explorateur britannique) s’appelle aujourd’hui Iqaluit (« les poissons » en inuktitut).

C’est donc la diversité des approches qui fait tout l’intérêt de cette revue consacrée à un sujet fondamentalement géographique : les terres.

Michèle Vignaux, décembre 2024

-

sur [Equipe Oslandia] Sophie Aubier, développeuse SIG

Publié: 19 December 2024, 7:25am CET par Caroline Chanlon

Après le BAC, le rêve de Sophie, c’est de tailler des pierres précieuses. Elle effectue un stage chez un artisan parisien où elle se rend vite compte que c’est un travail précaire qui est soumis à des règles qui ne lui conviennent pas.

Elle décide d’en apprendre plus sur la formation des roches et s’oriente vers une Licence de Géosciences à Paris Sorbonne puis un master de Physique de l’Océan, de l’Atmosphère et du Climat qu’elle complète avec un Master d’Hydrogéologie à Paris Saclay pour « plus de pratique et moins de théorie ».« Je me suis intéressée à la géologie pour finalement plus me passionner pour le calcaire que pour les pierres précieuses ! »

Pendant ses études, Sophie réalise plusieurs stages pendant lesquels elle mobilise les grands modèles utilisés par le GIEC pour les prédictions afin de réaliser des modélisations du climat.

« J’ai beaucoup utilisé Python dans mes stages et c’est ce qui me plaisait. J’avais envie d’apprendre encore sur le code, résoudre des problèmes scientifiques avec du code informatique. »

Sophie postule à une offre d’emploi chez Oslandia à un poste de développeur SIG junior. Elle est embauchée en janvier 2022 pour notamment développer des plugins QGIS en Python.

Projets emblématiques- Développement du plugin Cityforge : intégration de bâtiments 3D dans QGIS. Un plugin réalisé dans le cadre de la R&D Oslandia.

- Développement du plugin ELAN pour INRAE : un plugin d’outils de gestion des eaux urbaines.

« C’est un outil d’aide à la décision pour le traitement des eaux usées, le déversement des eaux de pluie et des eaux usées «

Python

PhilosophieApprendre !

Oslandia en 1 motAutonomie

-

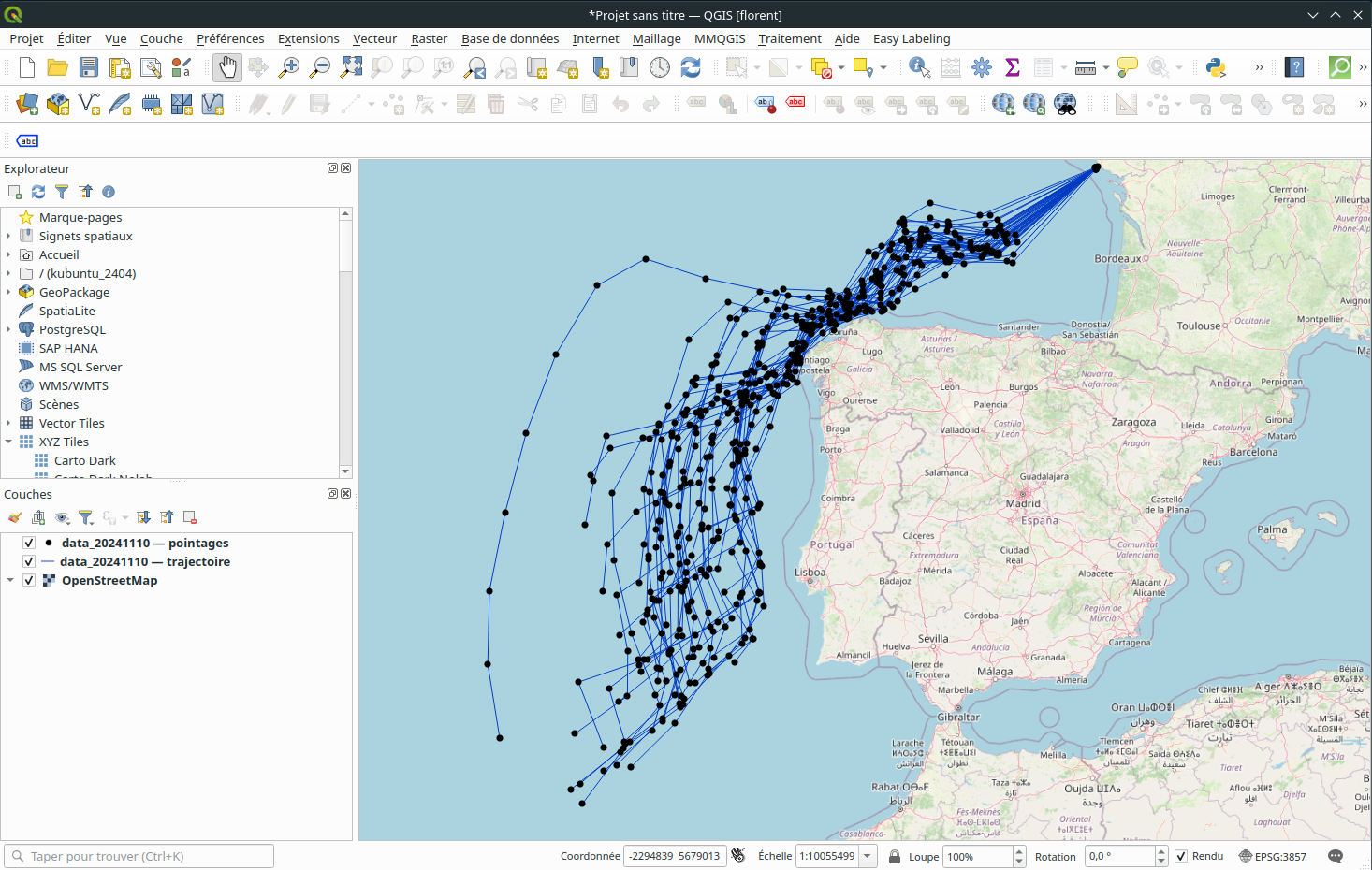

sur Suivre le Vendée Globe 2024 depuis un SIG - Partie 2

Publié: 18 December 2024, 2:00pm CET

Après avoir récupéré, nettoyé et visualisé les données SIG du Vendée Globe 2024 dans QGIS, voyons comment automatiser tout cela et développer une application application Web de suivi avec MapLibre.

Après avoir récupéré, nettoyé et visualisé les données SIG du Vendée Globe 2024 dans QGIS, voyons comment automatiser tout cela et développer une application application Web de suivi avec MapLibre.

-

sur Regard d'Altitude : recenser les effets du changement climatique sur les milieux alpins

Publié: 18 December 2024, 9:30am CET par Bastien Potiron

Dans un contexte de perte de connaissance territoriale et d’accroissement du dérèglement climatique affectant particulièrement les milieux montagneux, le projet Regard d’Altitude vise à structurer et centraliser de manière collaborative les observations des phénomènes naturels se produisant.

-

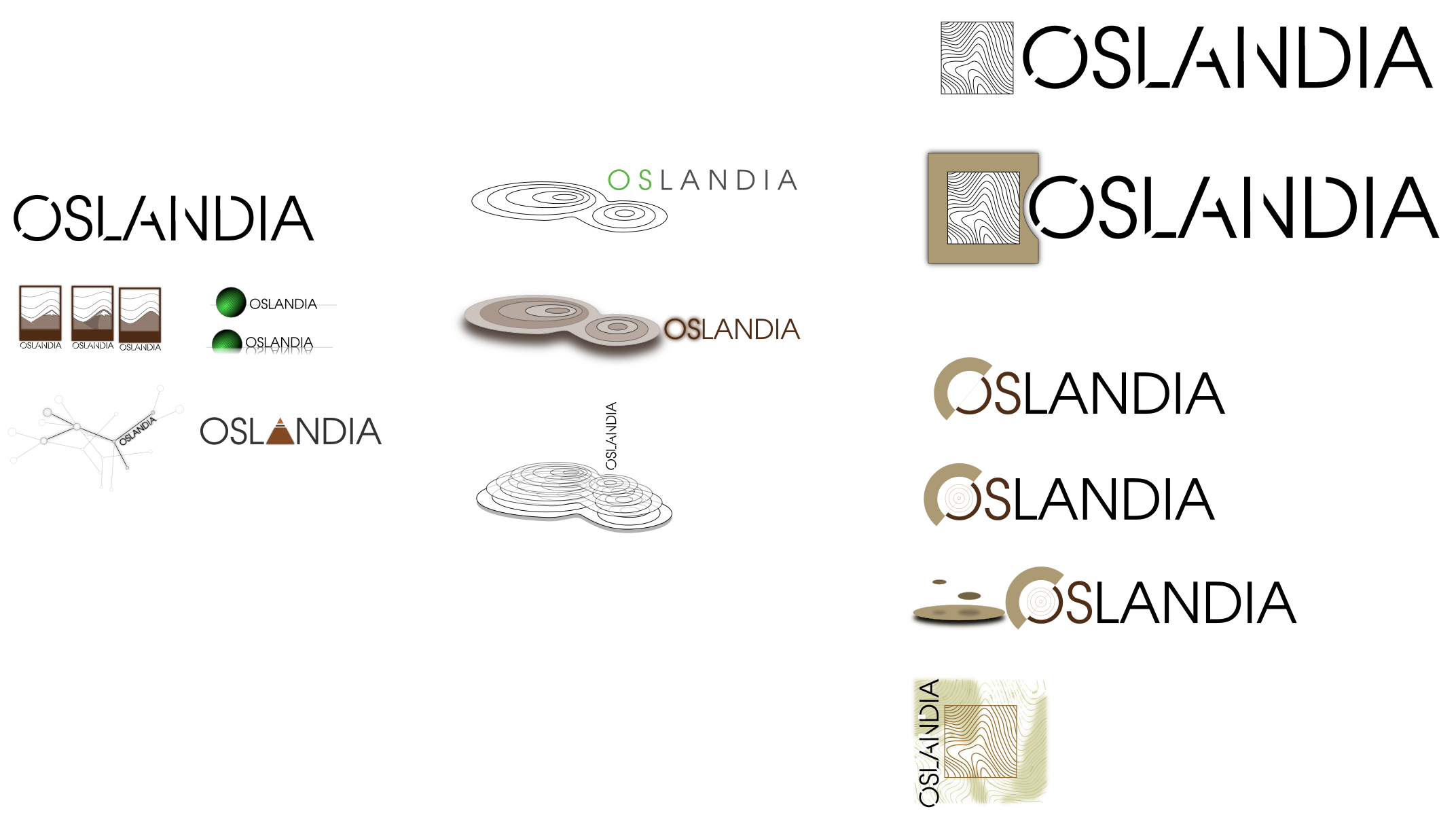

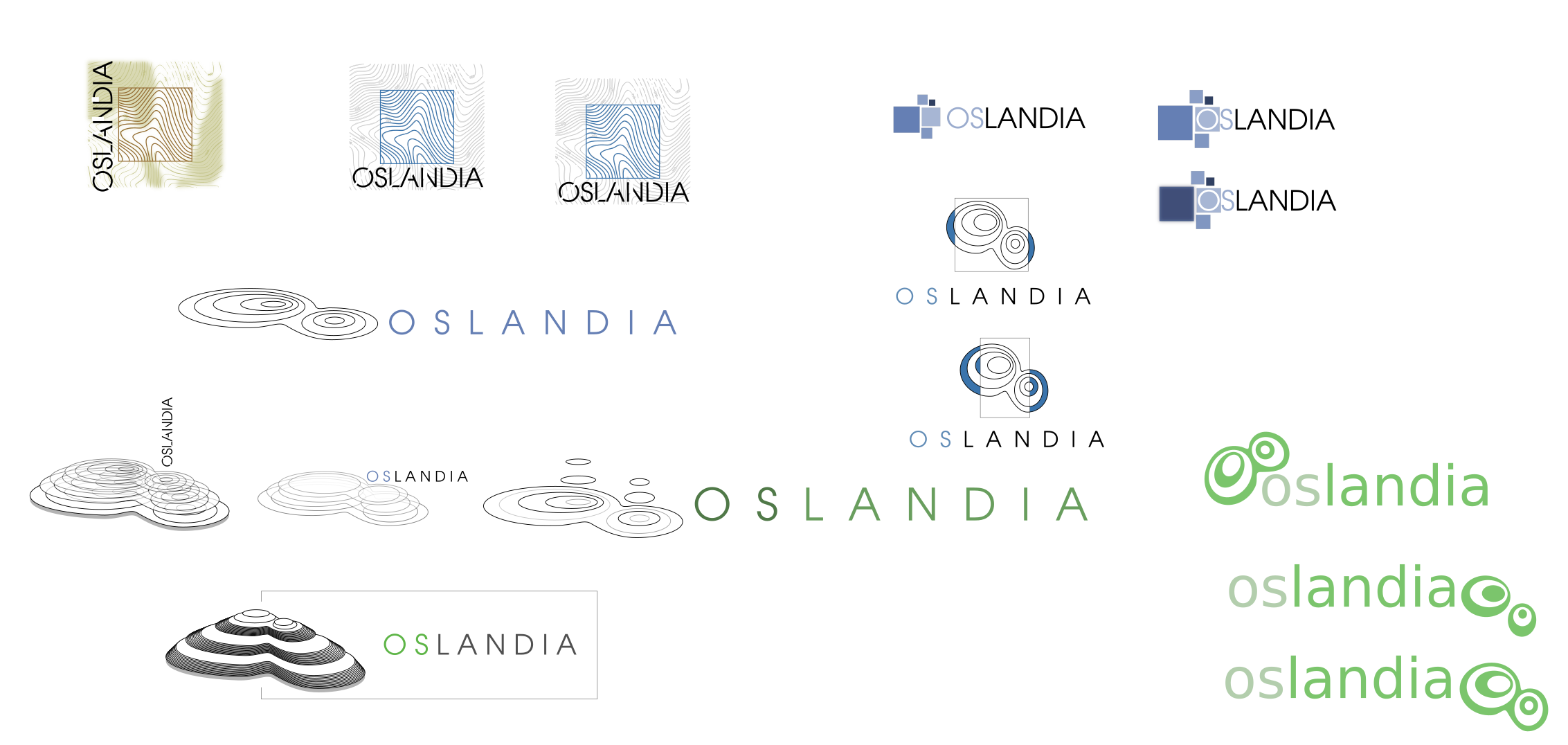

sur Petite histoire du logo Oslandia

Publié: 18 December 2024, 7:18am CET par Caroline Chanlon

Fin 2009, Oslandia est sur le point d’être créée… et a besoin d’une identité visuelle. Vincent contacte son ancien collègue Sylvain pour travailler sur un logo.

Le cahier des charges est lancé !Le logo doit être identifiable immédiatement, le plus simple possible (“ça va ensemble” dixit Sylvain), déclinable au trait (N&B), niveau de gris, quadrichromie, 256 couleurs et couleurs pleines. Il faut aussi qu’il soit symbole de dynamisme, avec une symbolique rattachée au métier, et ne ressemblant à rien de connu !

La première série d’idées ne se fait pas attendre, voilà quelques logos proposés :

Les partages d’idées se font via des emails et sont centralisés sur un wiki. Les premiers échanges débutent ! Et une série de modifications qui donne lieu à une nouvelle itération.

On avance !

Pour s’approcher d’une version finale

Qui ne tarde pas à arriver !

Retour d’expérience de Sylvain

« J’ai exclusivement travaillé avec Inkscape, toujours en vectoriel et uniquement à la souris. Sur ce type d’exercice, je n’ai pas besoin de crayon pour élaborer des ébauches, je pars souvent d’une forme géométrique simple ou d’un texte. Je me suis basé sur mon intuition pour les premières séries et les itérations m’ont permis d’avancer pas à pas. «

Au final, le logo Oslandia représente une sorte d’intersection spatiale entre des courbes de niveau ( une île ? ) et un rectangle, qui fait le lien avec le nom de l’entreprise.

Certains y voient cependant plutôt des attracteurs étranges, ce qui in fine pourrait aussi nous caractériser !

Le logo s’est construit à l’image d’Oslandia : de manière collaborative, démocratique, par itération et tout cela dans un soucis d’excellence et de travail bien fait

Depuis, le logo a évolué pour aboutir à la version actuelle. Cette nouvelle version, largement inspirée de la précédente, est simplifiée et modernisée. Elle est toujours facile à intégrer sur des pages web, des affiches ou des documents, et elle corrige le bug de la version précédente : un affichage possible au format carré !

-

sur Qu’est-devenue la Yougoslavie ? Avec Jean-Arnault Dérens et Laurent Geslin

Publié: 17 December 2024, 8:28pm CET par r.a.

De gauche à droite, Jean-Arnault Dérens, Laurent Geslin et Daniel Oster, mardi 26 novembre 2024, au Café de la Mairie (Paris 3ème) (Photo Denis Wolff)

La salle du premier étage du Café de la Mairie (Paris 3ème) était comble mardi soir 26 novembre pour écouter deux éminents spécialistes des Balkans, Jean-Arnault Dérens (JAD) et Laurent Geslin (LG). Les intervenants, tous deux journalistes, notamment au Courrier des Balkans et pour de nombreux organes de presse (Le Monde diplomatique, Mediapart, etc.), auteurs de plusieurs livres sur la région des Balkans, étaient présents pour faire le point sur la situation de l’espace ex-yougoslave, trente ans après la dislocation de la Yougoslavie socialiste de Tito.

J-A.D. : D’où vient l’idée yougoslave, c’est-à-dire l’idée de réunir tous les Slaves du Sud dans un même Etat ?

Cette idée apparaît au XIXème siècle, dans les années 1860, portée par des intellectuels croates, vivant donc dans l’Empire des Habsbourg. Elle est contemporaine du mouvement des nationalités qui se développe alors en Europe, notamment dans les Etats italiens et germaniques. Dès 1850, une base grammaticale commune a été fixée par une convention pour le serbo-croate, langue commune de ces populations slaves du Sud. Malgré leurs différences historiques et confessionnelles, ces populations formaient donc un ensemble ayant toute légitimité à se regrouper au même titre que les populations italiennes ou allemandes par exemple. Les guerres balkaniques de 1912-1913 et la Grande guerre de 1914-1918 favorisent la formation en 1918 d’un Royaume des Serbes, des Croates et des Slovènes qui prend le nom de royaume de Yougoslavie en 1929. Cet Etat est en réalité une construction politique grand-serbe qui nie tous les rêves d’unification de ces peuples slaves du Sud.La Seconde Guerre mondiale provoque la naissance d’une « seconde Yougoslavie », fédérative et socialiste, proclamée le 29 novembre 1943, qui va durer 45 ans avec une représentation assez équilibrée de toutes les nationalités (6 républiques, 2 républiques autonomes, soit le modèle de l’organisation étatique de l’URSS). Cette Yougoslavie « titiste » (Tito la dirige de 1943 à 1980, date de sa mort) s’effondre pour des raisons externes et internes. Sur le plan extérieur, elle perd son importance géopolitique de « pont » entre les deux parties du monde bipolaire de la guerre froide, elle est en quelque sorte la principale victime collatérale de la chute du mur de Berlin. Sur le plan intérieur, elle a évolué vers une sorte de confédéralisme marqué par des tensions accrues entre les républiques, principalement de nature économique. Les républiques les plus riches (la Slovénie grâce à son industrie, la Croatie grâce au tourisme) ne supportent plus de verser beaucoup d’argent en direction des républiques les plus pauvres (phénomène comparable entre le Nord et le Sud en Italie).

L’éclatement tragique de la Yougoslavie dans les années 1990 se fait dans la guerre. Aujourd’hui, le souvenir de la Yougoslavie reste bien présent dans les pays qui en sont issus. Face aux crises à répétition que traverse l’espace post-yougoslave, nombreux sont ceux qui regrettent « ce passé où l’on vivait mieux ». C’est la « yougonostalgie ».

A l’issue des guerres yougoslaves, les nouveaux Etats créés à partir des anciennes républiques étaient tous supposés rejoindre l’Union européenne. Ce qui est le cas pour la Slovénie en 2004 et finalement pour la Croatie en 2023. Mais constatons qu’il n’en est rien pour tous les autres Etats qui sont toujours candidats pour entrer dans l’UE (et même « candidat potentiel » pour le Kosovo). L’absence de frontières cadastrées en Serbie, en Bosnie-Herzégovine et au Monténégro facilite dans les années dans les années 2010 d’ailleurs les contentieux interétatiques même si l’émergence d’une « yougosphère » émerge dans les années 2010 avec les incertitudes de l’intégration européenne et la prise en compte de similitudes, notamment culturelles, dans tout l’espace autrefois yougoslave.

L.G. : Où en est-on aujourd’hui ?

Depuis 20 ans, l’espace post-yougoslave fait l’objet d’un double discours : d’un côté, l’UE et les dirigeants régionaux rappellent l’objectif d’entrée dans l’UE ; d’un autre côté, l’UE comme les dirigeants des Balkans occidentaux se satisfont de la situation politique actuelle. Plusieurs raisons à cela. Pour l’UE les Balkans occidentaux représentent, surtout depuis 2010, un sas sur la route migratoire qui aboutit à l’Europe occidentale. Ce sas permet de freiner et de contrôler les flux migratoires, des camps de rétention sont installés, des subsides sont versés aux pays de transit. Les Balkans forment ainsi une barrière et jouent un rôle d’amortisseur à la migration.Il y a également des raisons d’ordre démographique au maintien du statu quo politique entre l’UE et les Balkans occidentaux. Malgré les difficultés actuelles, ceux-ci ont des populations bien formées grâce à des systèmes éducatifs qui restent de bonne qualité. Les pays d’Europe occidentale, en particulier l’Allemagne, considèrent le Sud-Est de l’Europe comme un réservoir de main d’œuvre, très qualifiée (médecins…) et peu qualifiée (boulangers, plombiers…). Ces départs d’actifs aggravent la situation démographique marquée par un déficit des naissances accentué, déficit qui existe d’ailleurs dans une grande partie du continent européen.

Un autre fait constitue un grand problème pour les populations des Etats ex-yougoslaves, celui des lacunes récurrentes de l’état de droit. Ce phénomène est largement ignoré par les dirigeants de l’UE. Les manipulations électorales, la corruption, sont monnaie courante dans les Balkans occidentaux. On comprend que certains dirigeants des Etats de la région ne souhaitent pas forcément l’adhésion à l’UE qui signifierait le strict respect des règles de l’état de droit.

Tout ceci sans compter deux points de blocage qui empêchent l’intégration européenne d’avancer : en Bosnie-Herzégovine (entre Croates et Bosniaques) et au Kosovo (non reconnu par 5 Etas de l’UE). Ajoutons la guerre en Ukraine depuis 2022 qui a rebattu les cartes géopolitiques avec, par exemple, la décision de la Serbie de ne pas soutenir les sanctions de l’UE prises contre la Russie. Une majorité des Etats de l’UE vient de décider que l’élargissement européen n’était pas encore opportun.

J-A.D. : Quel est le rôle des puissances comme la Chine, la Turquie et le Moyen-Orient dans l’espace autrefois yougoslave ?

Au début du XXème siècle, la situation dans les Balkans montrait les rapports complexes entre les petits Etats balkaniques et les grandes puissances de l’époque, soucieux de jouer des rapports de force afin de renforcer leurs intérêts respectifs. Aujourd’hui, il en va de même avec les petits Etats anciennement yougoslaves qui exploitent la concurrence, notamment entre les Occidentaux et les Chinois ou les Turcs. Dans le même temps, les grandes puissances investissent dans la région pour pousser leurs pions économiques et/ou géopolitiques.Alors que l’UE apparaît comme le principal acteur extérieur depuis la crise de 2008, de nouveaux acteurs jouent un rôle important dans cette partie de l’Europe : avant tout la Turquie, la Russie, la Chine, les pays du Golfe arabo-persique. Au point que des questions se posent aujourd’hui avec plus ou moins de pertinence : la Turquie est-elle de retour dans les Balkans ? La Serbie est-elle le cheval de Troie dans la région ? La Chine est-elle en train d’acheter les Balkans ? Pourquoi les pays du Golfe investissent-ils dans cet espace européen ?

Depuis l’arrivée au pouvoir d’Erdogan et de l’AKP, les investissements turcs se sont généralisés dans les pays post-ottomans mais différents facteurs internes et externes ont modifié les priorités d’Ankara, mobilisée sur d’autres fronts. Et aujourd’hui la Turquie mise davantage sur la Serbie que sur la Bosnie-Herzégovine ou l’Albanie.

Les intérêts économiques de la Russie sont relativement modestes dans les Balkans, mais la région occupe une place symbolique importante dans les préoccupations du Kremlin. Si la Serbie n’a pas adopté les sanctions européennes contre la Russie après l’invasion de l’Ukraine, elle s’oppose en revanche à l’effondrement de l’intégrité territoriale de tout Etat membre de l’ONU (sans doute en pensant au cas du Kosovo).

Ce n’est que depuis la fin des années 2000 que les Balkans sont devenus une cible importante de la projection de la Chine à l’étranger (lancement en 2013 de la « Nouvelle route de la soie » entre Pékin et l’Union européenne). Plusieurs chantiers chinois ont été réalisés en Serbie et au Monténégro, particulièrement dans les infrastructures de transports, les minerais et l’éolien.

Quant aux pays du Golfe (Arabie saoudite et Emirats arabes unis, leurs investissements privilégient le tourisme, l’immobilier et l’armement, notamment en Serbie.

L.G. : Qu’en est-il de l’évolution de certaines régions comme la Dalmatie croate ou d’espaces particuliers comme les îles ?

La Dalmatie a connu un important essor du tourisme dès les années 1970-1980. Elle profite largement de la reprise touristique depuis la fin de la guerre civile à la fin des années 1990 au moment même où la transition économique post-communiste provoque la désindustrialisation de la côte adriatique (disparition des chantiers navals, etc.). Les méfaits du surtourisme sont aggravés par le manque de main d’œuvre régionale (Indonésiens, Philippins et d’autres nationalités sont employés pendant la saison touristique). Avec Airbnb c’est une société à deux vitesses qui se développe en bénéficiant aux propriétaires de maisons et d’appartements pouvant être loués tandis que le reste des populations locales subit surtout les prix élevés à Split, Zadar, etc. Les îles de la mer Adriatique sont particulièrement affectées par les difficultés et la déprise démographique.QUESTIONS DE LA SALLE :

Q1 : Pourquoi les Etats anciennement yougoslaves ne connaissent-ils pas des mobilisations populaires comme celles qui ont existé (Ukraine) ou qui existent (Géorgie) ?

Les mobilisations populaires existent dans les Balkans occidentaux, notamment en Serbie et au Monténégro, mais elles ne brandissent plus les drapeaux européens contrairement à ce qu’elles faisaient il y a 15 ans. Les raisons de ces manifestations peuvent être d’ordre écologique (par exemple, contre l’ouverture de mines de lithium en Serbie), ou dénoncer la corruption (par exemple, à la suite de l’accident mortel lié à un effondrement en gare de Novi Sad en novembre 2024). Sur tous ces problèmes les ambassades européennes se taisent, laissant les gouvernements locaux réagir …ou ne pas agir. De plus, le départ massif des actifs vers l’Europe occidentale entame la capacité de réaction de la société civile.Q2 : Comment décrire la situation actuelle au Kosovo ?

Les relations entre la Serbie et le Kosovo sont à la fois intimes, complexes et mauvaises. Pour les Serbes le Kosovo représente le centre historique et religieux de la Serbie au Moyen Age. Mais les albanophones, musulmans pour la plupart, forment aujourd’hui plus de 90% de la population. Pour comprendre cette évolution, il faut remonter à la « grande migration » de 1689. Une grande part de la population chrétienne, notamment serbe, quitte le Kosovo en suivant les armées autrichiennes par crainte de la répression ottomane. Depuis, la balance démographique n’a cessé de peser en faveur des Albanais et au détriment des Serbes. L’exode des Serbes (mais aussi des Roms, voire des Bosniaques) après la guerre de 1998-1999 a renforcé un processus engagé de longue date.Le dialogue entre le Kosovo et la Serbie a-t-il une chance d’aboutir alors que l’indépendance proclamée par le Kosovo en 2008 est toujours contestée par la Serbie. L’UE a pris en 2011 l’initiative d’initier un dialogue « technique » sur les problèmes concrets des citoyens concernés. Constatons que l’existence des Serbes au Kosovo est plus compliquée de jour en jour, ceux-ci d’ailleurs étant utilisés comme des pions par Belgrade.

Q3 : Quel rôle ont joué et jouent encore les différentes religions dans l’espace autrefois yougoslave ?

Rappelons que les guerres de Yougoslavie n’ont pas été des guerres de religion. D’ailleurs la Yougoslavie socialiste a été touchée par une vague profonde de sécularisation. Pendant la guerre civile, les religions orthodoxe, catholique et musulmane ont été utilisées, manipulées par les pouvoirs politiques, comme marqueur identitaire (durant le conflit en Croatie) et surtout comme facteur de légitimation politique. De leur côté, les hiérarchies religieuses ont commis l’erreur de ne pas se distancier assez clairement de cette récupération politique. Encore aujourd’hui, la clé du problème réside moins dans les Eglises que dans la manière dont les pouvoirs utilisent ces Eglises et les communautés confessionnelles. Ajoutons, pour le cas de l’islam, la lutte d’influence entre la Turquie et les pays du Golfe pour le contrôle des communautés islamiques.Q4 : Les Cafés géographiques organisent en mai 2025 un voyage à Trieste et en Istrie (Slovénie et Croatie). Que retenir de ce petit morceau de l’ancienne Yougoslavie, aujourd’hui faisant partie de l’Union européenne ?

Trieste, l’Istrie et la Dalmatie, c’est-à-dire la plus grande partie du rivage oriental de la mer Adriatique, forment une ligne de fracture majeure de l’espace européen. « Rideau de fer », « frontières de sang », frontières fantômes », sont quelques expressions qui ont été utilisées à propos de Trieste et de ce petit morceau de Yougoslavie appartenant aujourd’hui à l’Union européenne. Et les deux intervenants d’évoquer un voyage maritime qu’ils ont fait des Balkans au Caucase à partir de Trieste, voyage qui a donné lieu à la publication d’un beau récit en 2018.ELEMENTS BIBLIOGRAPHIQUES :

Jean-Arnault Dérens et Laurent Geslin, Les Balkans. Carrefour sous influences, Tallandier, 2023

Sous la direction de Jean-Arnault Dérens et Benoît Goffin, Balkans, collection Odyssées, ENS Editions, 2024

Jean-Arnault Dérens et Laurent Geslin, Là où se mêlent les eaux, La Découverte, 2018

Jean-Arnault Dérens, Adriatique. La mer sérénissime, collection L’âme des peuples, Editions Nevicata, 2024Compte rendu rédigé par Daniel Oster, décembre 2024

-

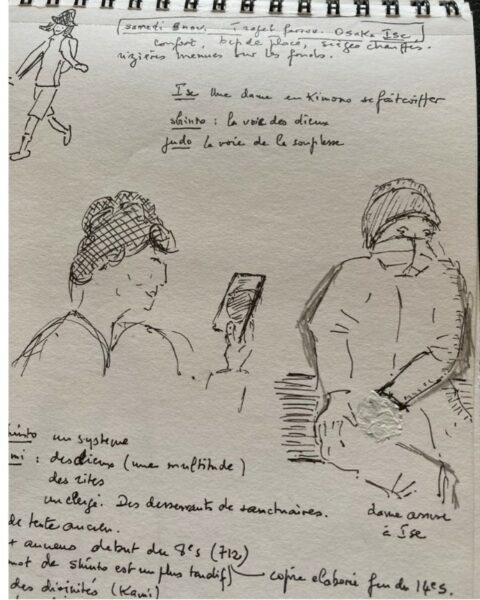

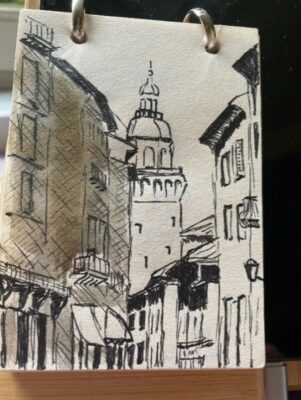

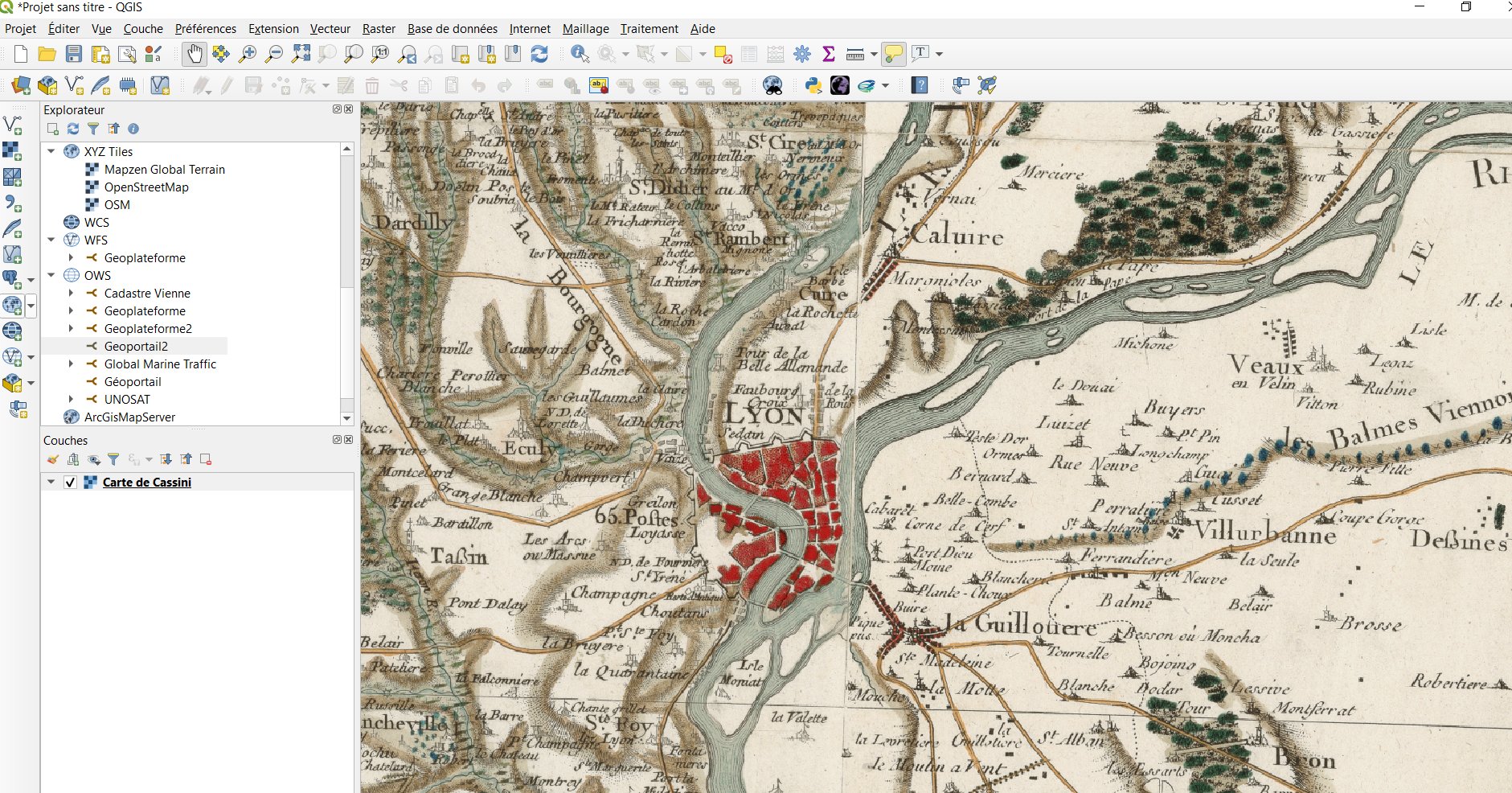

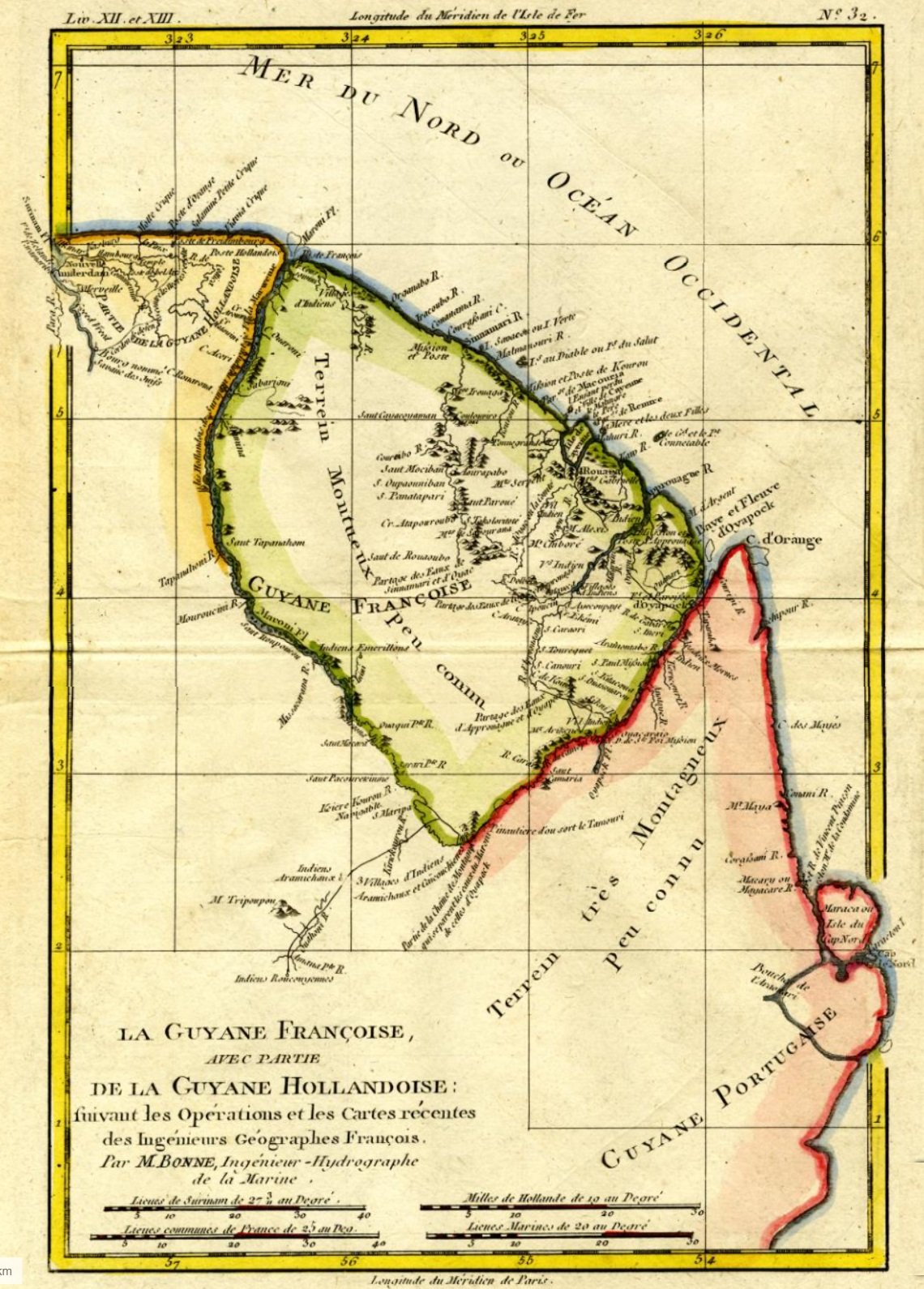

sur ICHC LYON 2024- Compte rendu d’une conférence réussie

Publié: 17 December 2024, 5:23pm CET par Emmanuelle Vagnon

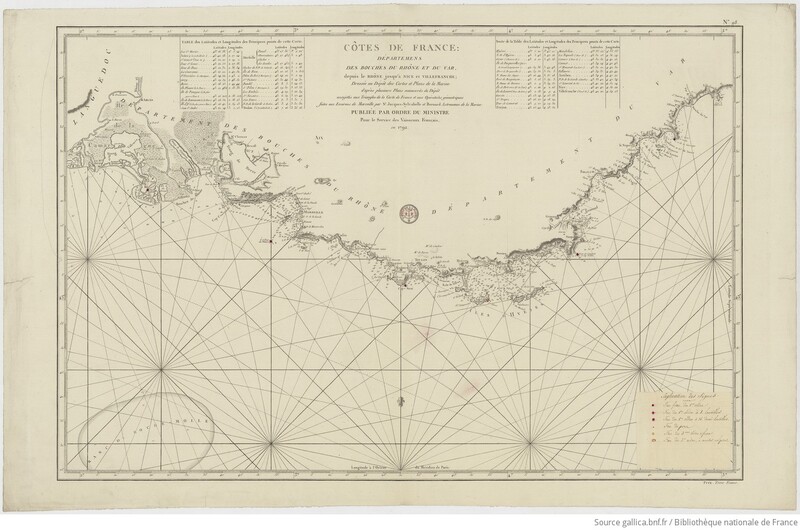

30e Conférence internationale sur l’histoire de la cartographie [ICHC], 1er au 5 juillet 2024- « Confluences – Interdisciplinarité et nouveaux défis dans l’histoire de la cartographie »

30th International Conference on the History of Cartography, 01-05 juillet 2024 – “Confluences – Interdisciplinarity and new Challenges in the History of Cartography”/

ICHC LYON 2024- Un projet collectifLa Conférence internationale sur l’histoire de la cartographie [ICHC] est le seul congrès consacré exclusivement à l’histoire des cartes et de la cartographie dans le monde. Depuis 1964, elle promeut une collaboration libre et sans entraves entre les cartographes de toutes les disciplines, les conservateurs, les collectionneurs, les marchands et les institutions. L’événement est fait de conférences illustrées, de posters, d’expositions et d’un programme social. Afin de mieux faire connaître les enjeux et les ressources, chaque conférence est parrainée par des institutions éducatives et culturelles de premier plan. Les conférences ont lieu tous les deux ans et sont administrées par des organisateurs locaux en collaboration avec Imago Mundi Ltd ( [https:]] ). La première participation française eut lieu en 1987 à Paris. La candidature de Lyon a été proposée et retenue pour 2024, après Amsterdam en 2019 et Bucarest en 2022.

Le comité d’organisation a été piloté par le professeur Bernard Gauthiez et sa collègue Enali De Biaggi, à l’Université Jean Moulin Lyon 3/UMR 5600 EVS (ichc2024@univ-lyon3.fr) et a compté avec la participation de nombreux collègues d’EVS.

Comité d’organisation

Enali De Biaggi (Université Jean Moulin – UMR 5600 EVS)

Bernard Gauthiez (Université Jean Moulin – UMR 5600 EVS)

Catherine Hofmann (BnF Département des cartes et plans)

Emmanuelle Vagnon – Chureau (Université de Paris I CNRS –

UMR 8589 – LAMOP)

Quentin Morcrette (CY Cergy Paris Université)

Claire Cunty (Université Lumière – UMR 5600 EVS)

Axelle Chassagnette (Université Lumière – LARHRA)

Damien Petermann (Université Jean Moulin – UMR 5600

EVS)

Marc Bourgeois (Université Jean Moulin – UMR 5600 EVS)

Virginie Chasles (Université Jean Monnet – UMR 5600 EVS)

Hélène Mathian (École Normale Supérieure CNRS – UMR

5600 EVS)Comité scientifique : Wouter Bracke, Tony Campbell,

Axelle Chassagnette, Imre Demhardt, Bernard Gauthiez, Nick

Millea, Emmanuelle Vagnon-Chureau

Secrétariat et comptabilité : Carla Wehbé

Communication : Emmanuelle Bruyas, Jean-Loup Miquel

Networking : Marine Préault

IT support : Jérémie Fernandes ; English editorial support : Francis HerbertUn grand merci aux étudiants et volontaires qui ont accompagné les invités !

La réalisation de la conférence à Lyon autour du thème : Confluences- Interdisciplinarité et nouveaux défis dans l’histoire de la cartographie visait également à renforcer les liens établis depuis les dernières années entre la communauté académique et les différences instances culturelles et administratives de la ville autour de l’approche cartographique, le tout avec une ouverture internationale. Ainsi, pendant la période allant d’avril à septembre 2024, 5 expositions ont été organisées (voir liste ci-dessous) et toute une série de conférences, visites guidées, master class et ateliers ont eu lieu pour discuter et rendre accessible à un public très large l’histoire de la cartographie, français et anglophone (traduction des cartels des expositions). Les partenaires pour les expositions ont été la Bibliothèque municipale de Lyon, les Archives du département du Rhône et de la métropole de Lyon, les Archives Municipales de Lyon, la Bibliothèque Diderot de Lyon à l’ENS, la Bibliothèque de la Manufacture de l’Université Jean Moulin Lyon 3

La réalisation d’un site web dédié ( [https:]] ) a été prise en charge par les services de l’université de Lyon 3, engagés également dans les services de logistique, sécurité, audiovisuel et accueil en général de l’événementiel. La Bibliothèque nationale de France a aussi été associée, de même que nombreuses autres institutions françaises : l’Université Lumière Lyon 2, le Laboratoire de Recherche Historique Rhône-Alpes LARHRA, le Laboratoire de Médiévistique occidentale de Paris LAMOP, le Comité Français de Cartographie/CFC, CY Cergy Paris Université. La conférence a pu compter sur le mécénat de l’Afigéo – Association française pour l’information géographique, de Business Geografic, CS Carto – Cyrille Suss Cartographe, de l’IGN et de Latitude Cartagène.

ProgrammeSix jours, du lundi 01/07/2024 au vendredi 05/07/2024 :

- 4 Séances plénières, 24 sessions de communications et une séance de posters

- Des vernissages autour d’un programme d’expositions originales le soir.

- 4 ateliers/workshops organisés en parallèle

- Une Map Fair

- Un espace d’exposition partenaires

Quelques thèmes déjà présents dans les conférences antérieures ont particulièrement été proposés :

- Évolution de la cartographie des villes et de leur planification.

- Nouvelles perspectives de la transition numérique.

- Imagerie du monde : cartes et autres images (livres d’art, manuscrits, guides, imprimés…).

- Cartes et environnement.

- Et tous autres aspects de l’histoire de la cartographie ont été abordés, selon les propositions faites par les participants.

Deux cérémonies ont ouvert et clôturé la conférence, dans des lieux prestigieux : le Grand Amphithéâtre de l’Université de Lyon 2 et au Musée des Confluences. Le reste de la semaine a eu lieu dans les locaux de l’IUT Lyon 3 et à l’UdL.

Une grande diversité de participants : Nous nous sommes attachés à donner la voix à différentes sensibilités et regards, respectant avec autant que possible la parité Homme-Femme, une plus grande représentativité des différents pays et régions (32 pour l’édition lyonnaise à partir de 35 pays d’origine des propositions) avec la conviction que nous ne pouvons qu’apprendre de la diversité.

Plus de 300 personnes se sont inscrites pour les différentes journées, dont 115 pour la présentation de communication orales et 20 pour la session de posters. Le recrutement de 8 étudiants.e.s-vacataires a permis de compléter une équipe de 10 personnes ressources. Le retour à un événement présentiel insistait sur l’occasion de renforcer nos liens d’amitié et d’imaginer de nouvelles formes de coopération pour la suite.

Expositions- Représenter le lointain : un regard Européen / Representing the far away: an European perspective (Bibliothèque Municipale de Lyon) – 2 avril – 13 juillet 2024

Représenter le lointain : un regard européen (1450-1950)

Qu’est-ce que le lointain ? Un autre monde, une contrée, un bout de terre ou de mer, un morceau d’univers qu’il est difficile – parfois impossible – d’atteindre et d’appréhender. Sa perception évolue dans le temps, en fonction des modes de vie, des projets politiques, des moyens techniques de celles et ceux qui le saisissent. Nous adopterons un point de vue : le lointain vu d’Europe et par les Européens entre 1450 et 1950 en s’interrogeant sur la dimension critique de ces représentations.

Evènements associés :

- Cartes marines et oeuvres d’art. Les atlas portulans de la Bibliothèque municipale de Lyon (XIVe-XVIIe siècle) – Emmanuelle Vagnon-Chureau, le 21/05/2024 ( [https:]] )

- Les écrivains américains et la cartographie – Julien Nègre, le 11/06/2024 ( [https:]] )

- L’exploration du monde : une autre histoire des Grandes Découvertes – Guillaume Calafat, le 6/06/2024 ( [https:]] )

- Mondes inférieurs et terres célestes : les géographies verticales de la modernité – Jean-Marc Besse, le 13/06/2024 ( [https:]] )

- Éditathon Wikipédia “Représenter le lointain” – le 13 juin 2024

- Le détail et l’ensemble. Cartes et images du territoire rhodanien et lyonnais / The detail and the whole. Maps and images of the Rhône and Lyon area (Archives départementales et Métropolitaines) – 4 avril – 12 juillet 2024

Les Archives départementales et métropolitaines proposent de suivre au fil du temps, la façon dont la représentation de l’espace de ces territoires a évolué. Les cartes doivent répondre à des fonctions différentes, de plus en plus variées et complexes. Certaines demandes s’observent cependant à toutes les périodes, comme lorsqu’il s’agit de valoriser des terres ou de fortifier des places. Lyon occupe naturellement une place à part : les villes ont très tôt fait l’objet de l’attention du politique et du militaire, et les enjeux de cartographie y sont particulièrement importants.

Evènements associés :

- Cartographier Lyon : quelle histoire en comparaison des autres villes ? Bernard Gauthiez et Agnès de Zolt, le 18/04/2024

- La grande histoire des cartes (Les rendez-vous avec l’INA) Film d’Eric Wastiaux, le 15 mai 2024

- La Guillotière depuis 200 ans : du cadastre napoléonien à nos jours – Pierre Chico-Sarro et Guy Milou, le 30 mai 2024

- Documentaires sur la cartographie (Les rendez-vous avec l’INA) : Projection de 3 documentaires : – La carte de France : son histoire (film de Gérard Dolet – 23′ – 1979) – Jeux de cartes (film de Dominique Planche – 25’ – 1990) – Pierre Novat, panoramiste alpin (Alpes Sud – 8’ – 1992), le 5 juin 2024

- Vulnérabilité … qu’en disent les cartes ? / Vulnerability … what do maps say? (Archives Municipales de Lyon) – 3 mai – 28 septembre 2024

La ville de Lyon est vulnérable à des événements variés, soudains ou au cheminement long et indécelable, jusqu’au moment où ils s’imposent et menacent. La plupart d’entre eux n’ont laissé que des mots, bien insuffisants à nous permettre de comprendre ce qui s’est passé, ni comment les hommes composaient avec. Cette histoire est parfois représentée sur des cartes ou par des images qui nous permettent d’en saisir l’ampleur et les particularités. La carte, de ce point de vue, est venue tardivement, accompagnant une vision de plus en plus nourrie scientifiquement. Cette exposition interroge la ville sous l’angle de ses vulnérabilités, au travers de documents rarement vus et encore moins montrés, alors que la ville d’aujourd’hui regorge de dispositifs instaurant la plus grande sécurité.

Evénements associés :

- Risques et territoire : le pari du paysage – CAUE 69, le 16 mai 2024

- Risques et mémoire : un tandem subtil ! – Antoine Le Blanc en partenariat avec la Géothèque, le 30 mai 2024

- À vos cartes – Mapathon/Atelier de cartographe sensible/Découverte des jeux cartographiques – le 1er juin 2024

- Projection & rencontre : Brise-lames de Jérémy Perrin et Hélène Robert et en avant-première Ingérentes et incurables, de Marie Cornen – Cinéma Comoedia et à partir de 14h, aux archives municipales, le 8 juin 2024

- La fabrique des cartes – atelier gratuit ouvert à tous, le 13 juin 2024

- Les défenses de Lyon – Pierre-Jean Souriac, le 13 juin 2024

- La carte de l’insurrection des canuts en 1834 et ses suites – Bernard Gauthiez, le 20 juin 2024

- Déjouer les risques (matinée jeux en famille) – le 12 juillet 2024

- Fabriquer une carte de A à Z – IGN, le 5 septembre 2024

- Cartes et archéologie à Lyon – Conférence de Mélanie Foucault et Hervé Tronchère, le 12 septembre 2024

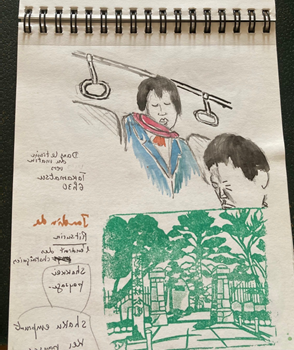

- Chemins de papier – Cartes et images du voyage en France et ailleurs, XIXe-XXIe siècle / Paper paths – Maps and images of travel in France and elsewhere, 19th-21st century (Bibliothèque Diderot de Lyon)15 mai – 22 septembre 2024

Les mobilités, phénomènes complexes, mêlent – entre autres – des dimensions technique, politique et culturelle. Pour les périodes récentes, elles s’accompagnent de la diffusion d’une grande variété de documents imprimés aux fonctions diverses, qu’il s’agisse d’aider le voyageur (guide ou carte touristique), de le faire rêver (fiction, iconographie), ou encore de reproduire le voyage (récit et itinéraire d’exploration). Entre le XIXe et le XXIe siècle, les mobilités individuelles se complexifient et s’intensifient en Europe. En lien avec celles-ci, les cartes et les guides, instruments indissociables du voyage et de sa représentation, connaissent de nombreuses transformations. Cette exposition retrace ces évolutions, depuis le guide imprimé jusqu’à l’écran tactile numérique.

Evènements associés :

- Parlez-nous de… Cartes et voyages – Quentin Morcrette et Damien Petermann, 23 mai 2024

- Enjeux et défis de la cartographie contemporaine à l’usage des voyageurs. Christophe Biez, Quentin Morcrette, Damien Petermann, Cyrille Suss, le 25 septembre 2024

- Teaching maps : sur les traces de la cartographie à l’université de Lyon/ Teaching maps: on the trail of cartography at the University of Lyon / (Bibliothèque universitaire de la Manufacture des Tabacs Lyon 3)

L’approche cartographique a accompagné les mutations de l’enseignement de la géographie depuis le XIXème siècle, toujours présente, sa place s’est peu à peu affirmée au sein de l’université de Lyon. C’est par le biais des productions et collections cartographiques des différents géographes et cartographes qui se sont succédés au sein des différentes universités de Lyon que nous vous proposons de suivre 150 ans d’analyses géographiques, parfois locales, parfois lointaines élaborées sur place. 18 juin – 22 septembre 2024

Evènements associés :

- Les cartes postales anciennes de Lyon (fin XIXe-milieu XXe siècle) – master class – Présentation par Enali De Biaggi, Michaël Douvégheant et Damien Petermann du projet d’indexation et de spatialisation des cartes postales anciennes de Lyon : étude géohistorique et valorisation numérique

- Mapathon : un atelier de cartographie collaborative sur OpenStreetMap – le 25 juin 2024

- Visites guidées de l’exposition – le 18 juillet 2024, le 9 septembre 2024, le 19 septembre 2024, le 20 septembre 2024, le 21 septembre 2024 (Journées du Patrimoine)

- Podcast Commun Campus – Le dessous des cartes ( [https:]] )

-

sur Récolt’Ô est le lauréat des Trophées Innovation aux Aqua Business Days 2024

Publié: 17 December 2024, 9:30am CET par Amandine Boivin

L’application Récolt’Ô de valorisation de l’eau de pluie remporte les Trophées Innovation Aqua Business Days 2024. Avec Récolt’Ô préservez votre territoire.

-

sur IASBIM, ou l’IA au service du BIM

Publié: 17 December 2024, 6:25am CET par Raphaël Delhome

Pièce jointe: [télécharger]

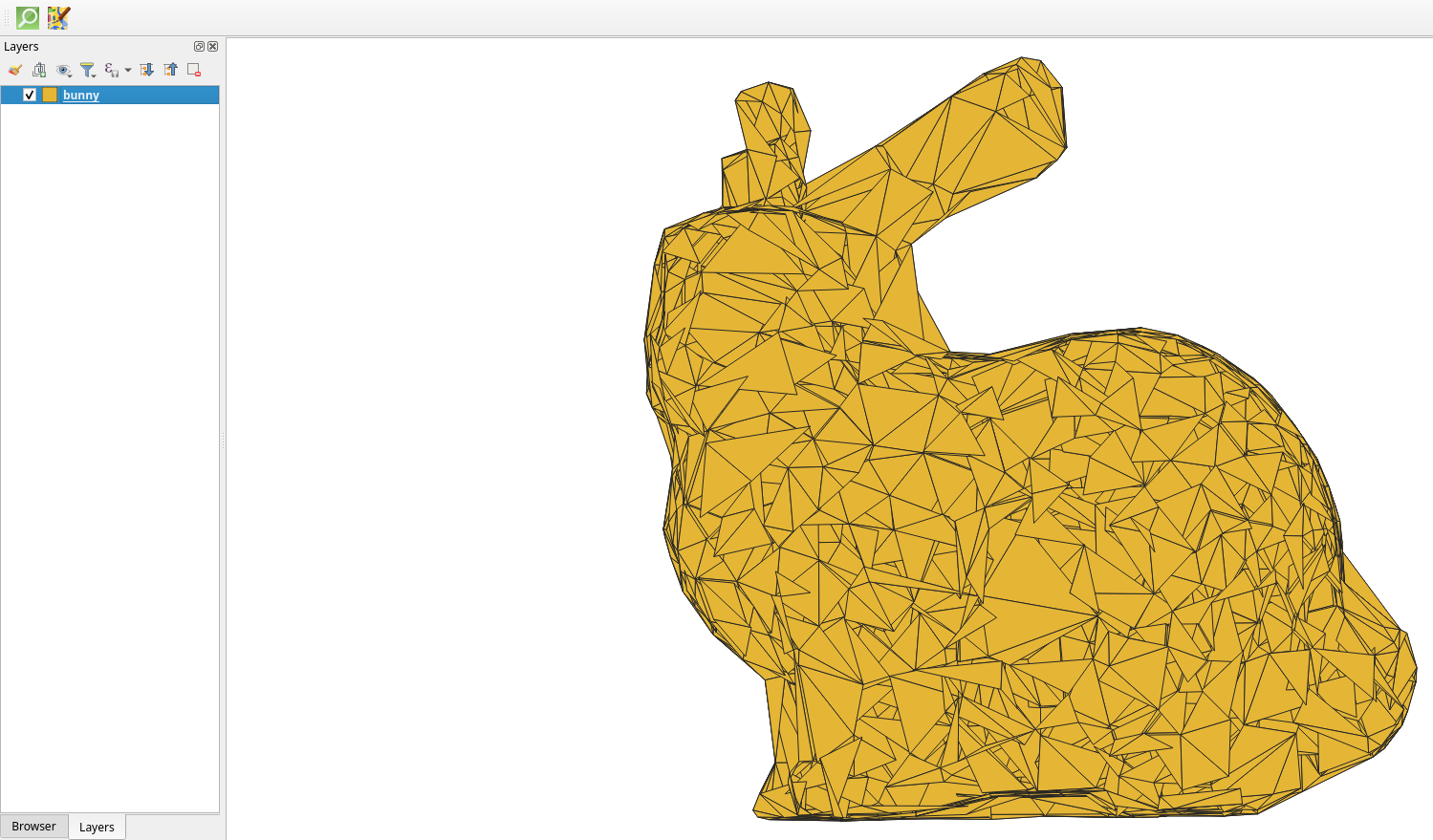

Oslandia s’est récemment illustré au côté de Bimdata et le LIRIS dans le cadre du projet IASBIM, un projet R&D Booster financé par la région Auvergne Rhône-Alpes.

Oslandia s’est récemment illustré au côté de Bimdata et le LIRIS dans le cadre du projet IASBIM, un projet R&D Booster financé par la région Auvergne Rhône-Alpes.L’occasion nous était donnée d’explorer les relations entre les données BIM et le couple Py3dtiles/Giro3D, ainsi que de découvrir le potentiel de la segmentation sémantique appliquée aux nuages de points en 3D.

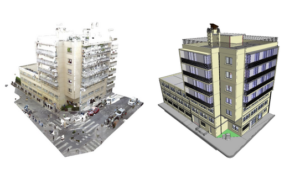

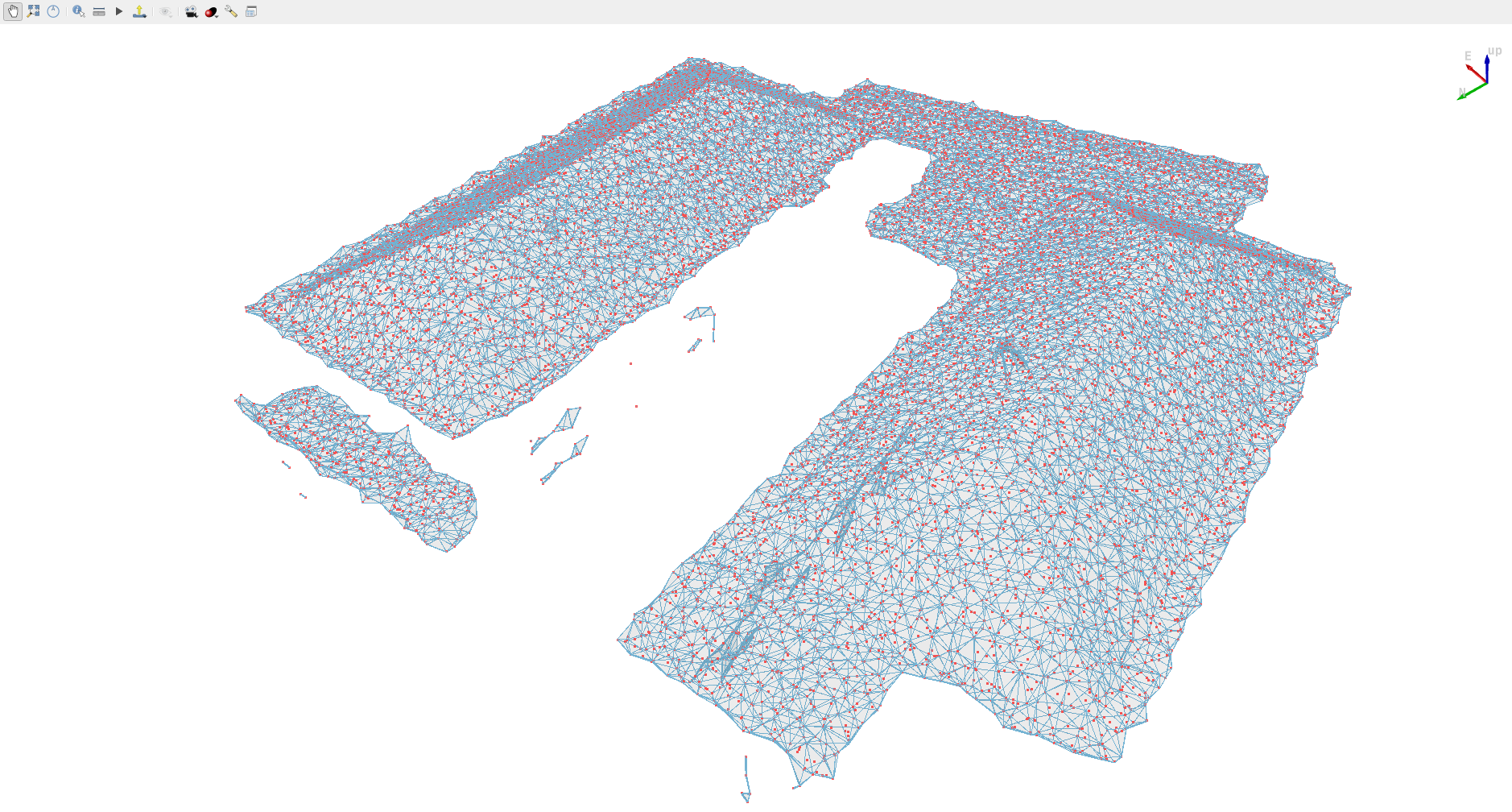

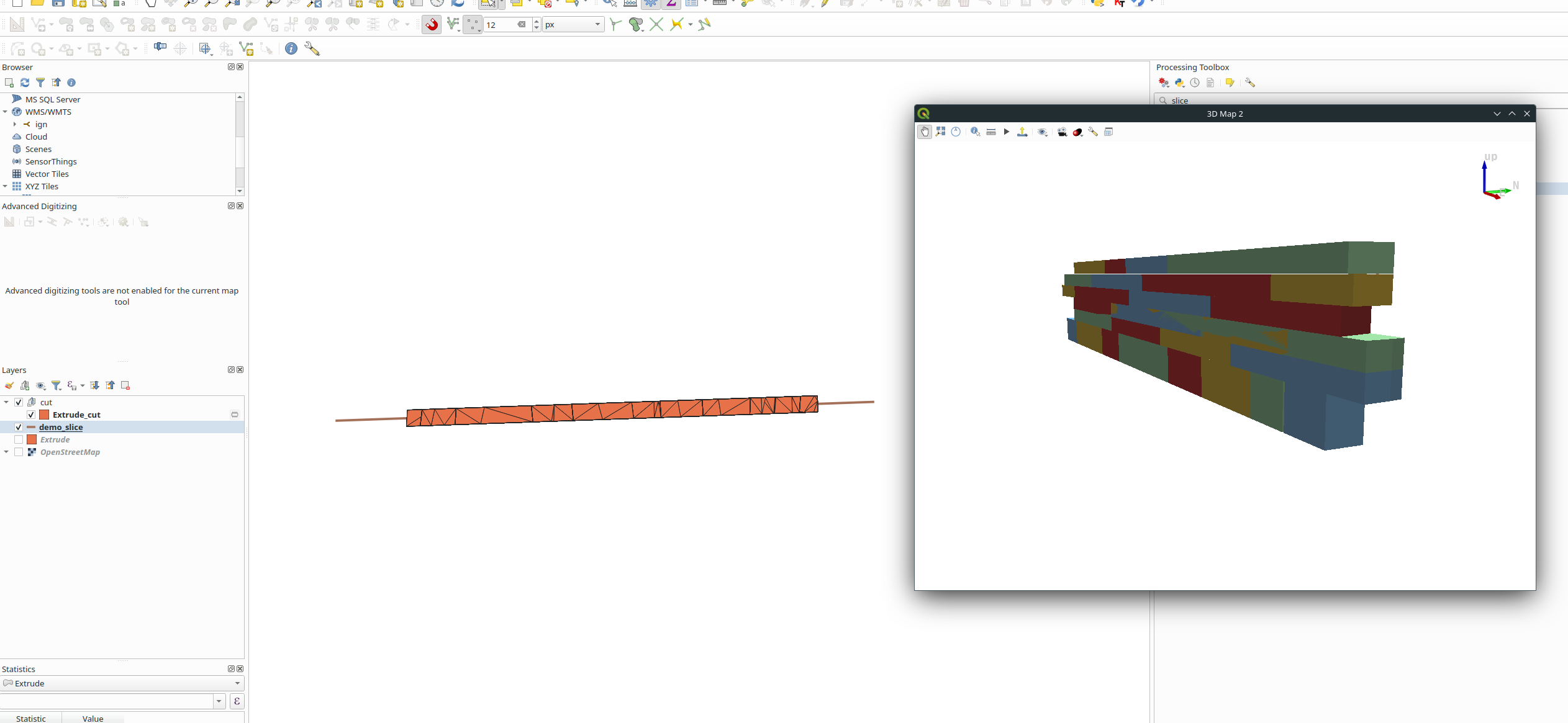

Contexte du projetLe projet IASBIM se proposait de mettre en avant les méthodes Scan-to-bim pour les acteurs du bâtiment et de la construction, en comblant le fossé entre les nuages de points 3D (captés notamment par Lidar) et les maquettes BIM (au format IFC). Dans cette optique, il s’agissait d’employer des méthodes d’intelligence artificielle et de reconstruction géométrique. Construire une méthodologie de scan-to-bim automatisée ou semi-automatisée peut ainsi permettre de participer à la transformation numérique du secteur de la construction.

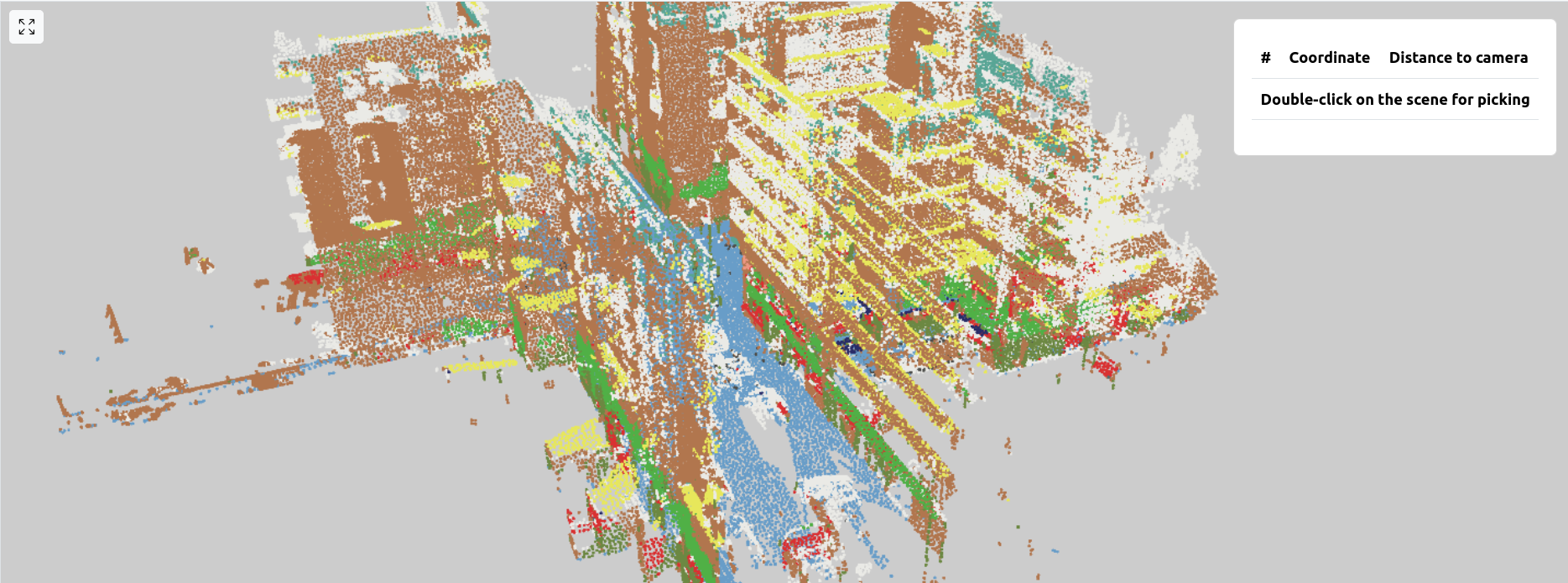

Scan-to-BIM: du nuage de points à la maquette BIM

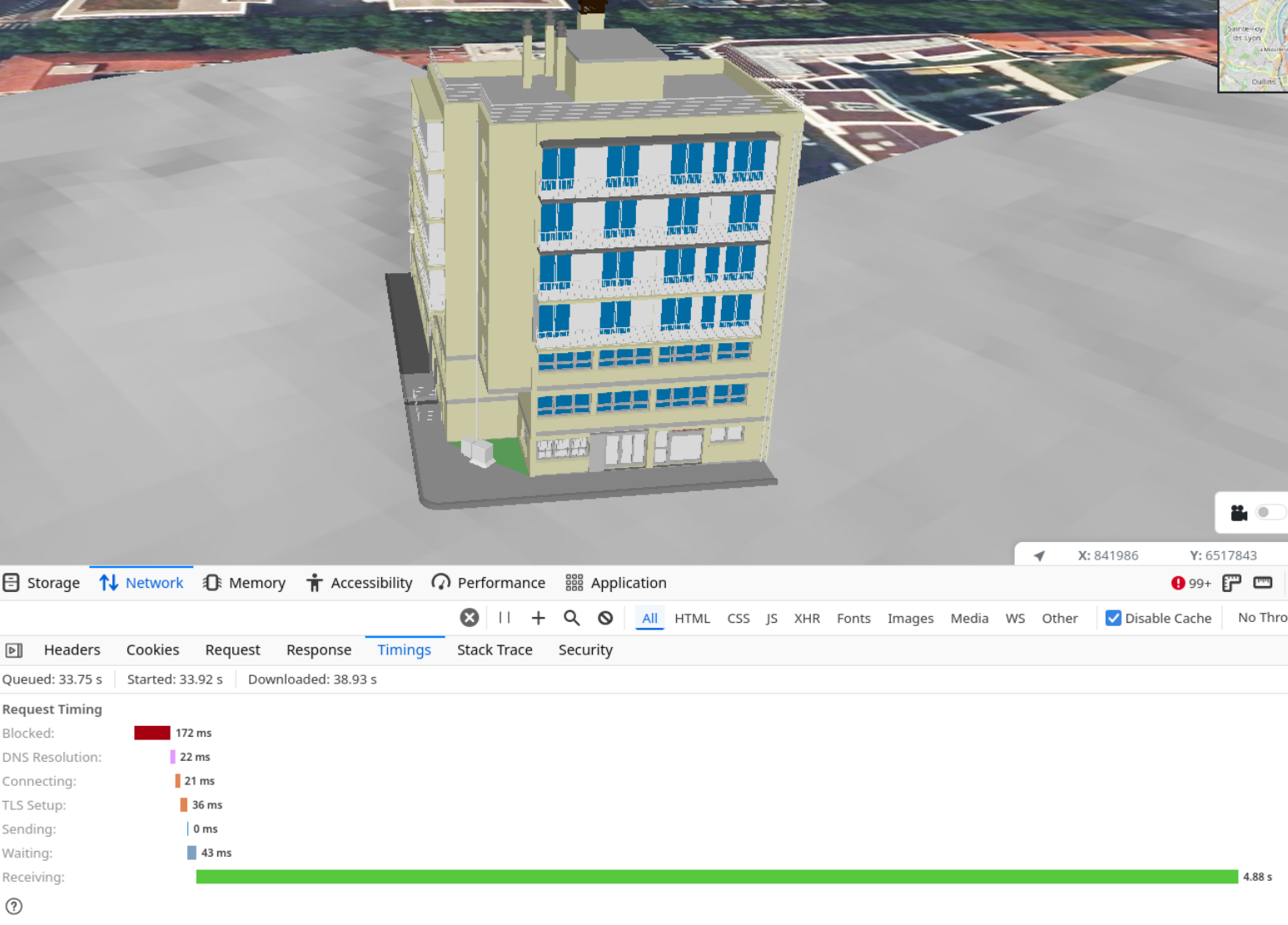

Vers un nouveau procédé de Scan-to-BIMAinsi, à partir de scans 3D opérés sur le terrain fournis par Bimdata, Oslandia a ainsi eu l’opportunité de mettre en oeuvre un algorithme de segmentation sématnique 3D pour produire des nuages de points annotés. Cette information, une fois transmise au LIRIS, a alimenté les algorithmes de reconstruction géométrique développé par le laboratoire. Enfin, les géométries obtenues ont été récupérées par Bimdata, pour finalement être transformées en maquette BIM. Ces maquettes sont proposées en visualisation dans la plateforme Bimdata, qui a la particularité d’exploiter Giro3D.

Chaîne de traitement de données construite à l’occasion de IASBIM

Réalisations OslandiaLes principaux chantiers pris en charge par Oslandia sont d’une part la visualisation web 3D, se décomposant en une partie backend représentée par Py3dtiles, pour le traitement amont des données 3D et une partie frontend représentée par Giro3D, et d’autre part, l’annotation sémantique de nuage de points, travail réalisé au moyen d’une implémentation de l’algorithme KPConv.

Visualisation web 3DPour la partie backend, nous avons pu établir l’importance de la hiérarchisation de la donnée BIM, avec le format 3DTiles ( [https:]] ), et détailler les éléments nécessaires à sa conversion vers ce format, notamment en respectant la hiérarchie intrinsèque des éléments constituant un jeu de données BIM ( [https:]] ).

Hiérarchie naturelle d’une donnée BIM

Du côté de la partie frontend, on peut noter qu’IASBIM a permis à la Giro3D de supporter l’affichage de maquettes BIM au format .ifc ( [https:]] ).

Affichage d’une maquette BIM au format IFC avec Giro3D

En guise de transition avec la partie suivante, dédiée à la segmentation sémantique, on notera également le support de la classification sémantique dans le viewer 3D ( [https:]] ).

Segmentation sémantique 3DEn guise de dernière partie impactante, notons enfin les avancées en matière de segmentation sémantique 3D, qui ont permis à Oslandia de se positionner sur cette technologie via une implémentation de l’algorithme KPConv. Nous avons choisi de travailler à partir de l’implémentation en Pytorch proposée par Hugues Thomas, et lui avons apporté un certain nombre de fonctionnalité pertinentes dans le cadre de IASBIM, via un fork ( [https:]] ). Cela nous a conduit à produire nos premières inférences sur des jeux de données exploités pendant IASBIM ( [https:]] ), ainsi qu’une feuille de route pour les prochaines étapes sur ce sujet !

Exemple de prédiction par KPConv en contexte outdoor, on note les murs en marron, le sol en bleu, les avancées de toiture en jaune, notamment

Pour aller plus loinSi vous désirez en savoir plus sur IASBIM, vous pourrez retrouver quelques informations supplémentaires sur le blog dédié au projet ( [https:]] ).

Vous êtes intéressés par les interactions entre modèles 3D et maquettes BIM, ou par la visualisation web de données 3D de manière plus générale ? N’hésitez pas à nous contacter via infos@oslandia.com pour en savoir plus !

-

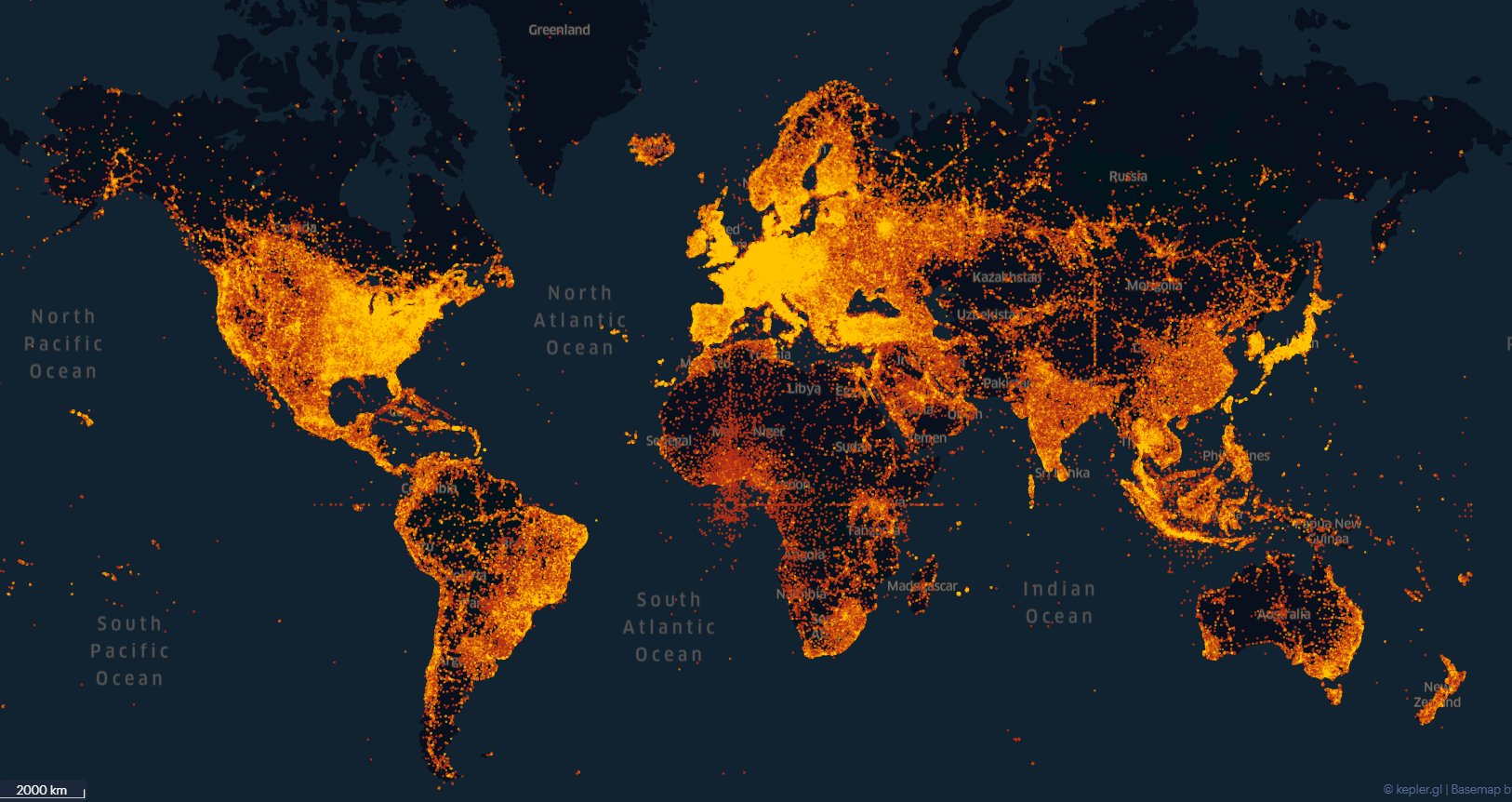

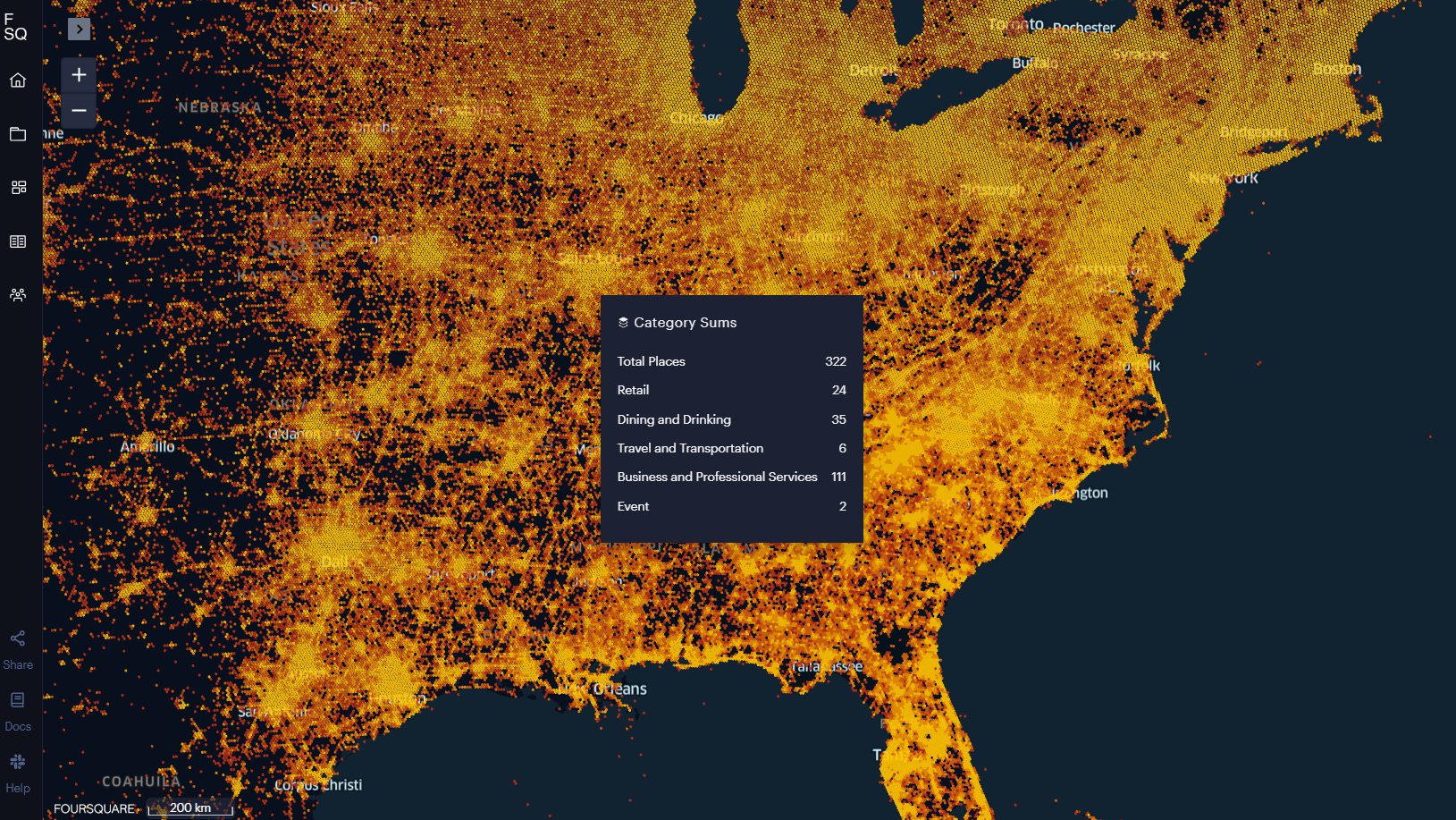

sur L'Overture Maps Foundation ambitionne de rivaliser avec Google et Apple

Publié: 17 December 2024, 6:21am CET

L'Overture Maps Foundation, constituée d'Amazon, Meta, Microsoft, Tom-Tom et d'autres "géants" de l'Internet, ambitionne de rivaliser avec Google et Apple dans les années à venir, avec de la donnée ouverte. Sa mission déclarée est « d'alimenter les produits cartographiques actuels et de nouvelle génération en créant des données cartographiques ouvertes, fiables, faciles à utiliser et interopérables »

1) Les objectifs du projet OvertureFondé en 2022, le projet Overture s'adresse aux développeurs qui créent des services cartographiques ou utilisent des données géospatiales. L’approvisionnement et la conservation de données cartographiques de haute qualité, à jour et complètes provenant de sources disparates sont difficiles et coûteux. Overture vise à intégrer des données cartographiques provenant de plusieurs sources, notamment des membres d'Overture, des organisations civiques et des sources de données ouvertes. L'enjeu est la création de cartes collaboratives.

Au delà de l'ouverture des données, l'objectif est également de proposer un système de référence partagé. Plusieurs ensembles de données font référence aux mêmes entités du monde réel en utilisant leurs propres conventions et leur propre vocabulaire, ce qui les rend difficiles à fusionner et à combiner. Overture Maps vise à simplifier l’interopérabilité en fournissant un système reliant les entités de différents ensembles de données aux mêmes entités du monde réel. Overture souhaite définir et favoriser l’adoption d’un schéma de données commun, bien structuré et documenté pour créer un écosystème de données cartographiques facile à utiliser.

Les données cartographiques sont vulnérables aux erreurs et aux incohérences. Les données d'Overture Maps seront soumises à des contrôles de validation pour détecter les erreurs cartographiques, les cassures et le vandalisme afin de garantir que les données cartographiques puissent être utilisées dans les systèmes de production.

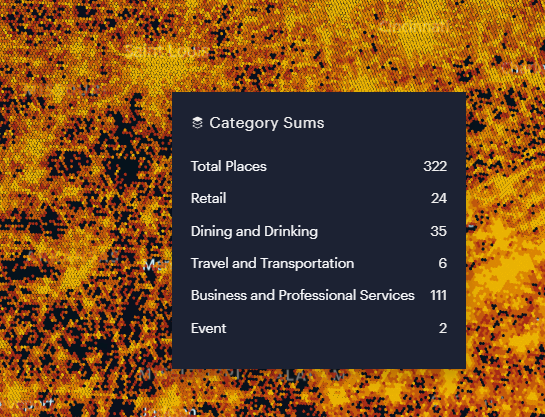

2) Les données mises à disposition

Les données sont disponibles au format GeoParquet V1.1.0, une norme en cours d'incubation de l'Open Geospatial Consortium qui ajoute des types géospatiaux interopérables au format Apache Parquet, via Amazon AWS et Microsoft Azure.

La première publication de données comprenait quatre « thèmes » :

- Lieux - Données sur les points d'intérêt (POI) sur environ 60 millions de lieux dans le monde

- Bâtiments - données sur l'empreinte et la hauteur des bâtiments pour 785 millions de bâtiments dans le monde

- Transports - données sur le réseau routier

- Limites administratives - limites administratives pour le niveau 2 (niveau du pays) et le niveau 4 (subdivisions de premier niveau sous le pays) dans le monde.

Ces données sont régulièrement enrichies et mises à jour. La version des données Overture 2024-10-23.0 est désormais disponible. Overture Maps Explorer permet d'avoir un aperçu des données mises à disposition. Les instructions pour accéder aux données sont disponibles sur le référentiel de données Overture Maps.

Le projet Overture se veut complémentaire du projet OpenStreetMap, et la fondation encourage les membres à contribuer directement aux données du projet OSM. On peut cependant s'interroger dans quelle mesure ces données sont vraiment ouvertes. Deux des quatre « thèmes » d'Overture Maps Foundation sont disponibles sous une licence ODbL et deux des thèmes sont disponibles sous une licence CDLA Permissive v 2.0.

This could be big... Even huge?

— Christopher Beddow (@cbed32) July 26, 2023

Overture Maps releases a global POI open dataset, an aggregate of Microsoft @bingmaps and @Meta places data.

Read more: [https:]] #openstreetmap #opendata #gischat pic.twitter.com/bYTFHigtRe? Unlock the power of Overture Maps data with Leafmap and MapLibre! Explore open-access global-scale data on buildings, transportation, places, addresses, basemaps, and more. Integrate open-access data into your workflow with Python ?

— Qiusheng Wu (@giswqs) August 22, 2024

? Notebook: [https:]]

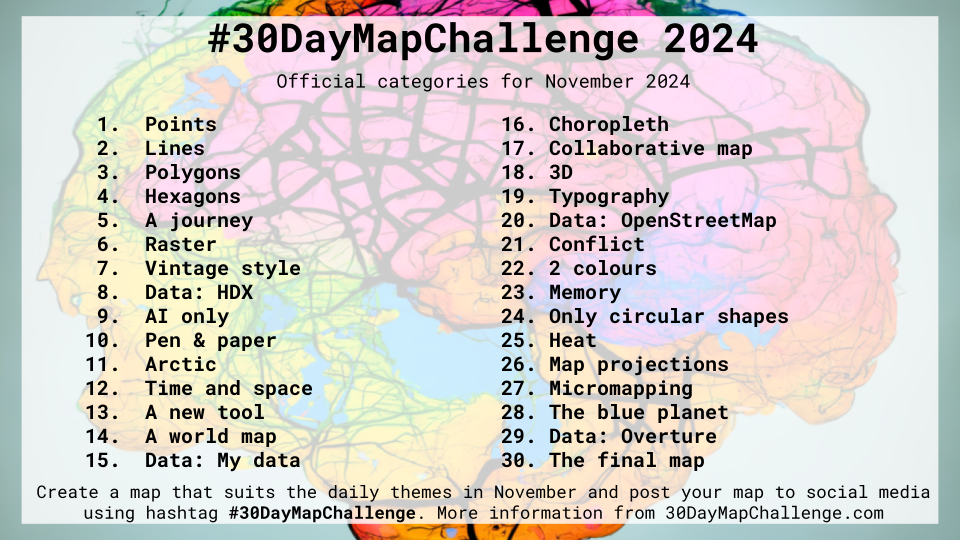

?… pic.twitter.com/qBt8oCGkXUDay 29. Overture #30DayMapChallenge Comparative Analysis of Building Data: OpenStreetMap vs Overture Maps Foundation in Ukraine pic.twitter.com/BZn7LKSAtD

— gontsa ?? (@gontsa) November 29, 2024#30daymapchallenge · JOUR 29 : "Source de données : Overture" ?#cartographie #map #carte #overture #sncf pic.twitter.com/l7Hp0dUISz

— Alexandre Médina (@A_Lex_Map) November 29, 2024Articles connexes

Open Source Places, une base de données de 100 millions de POI en open source (Foursquare)

AllThePlaces : géodonnées et vision du monde commercial à travers Internet

Cartes et données sur la population mondiale (Population & Sociétés, 2024)

Guide de l'Insee pour faciliter l’accès aux données

Jeu de données SEDAC sur l'évolution des villes dans le monde entre 1975 et 2030

Geonames, une base mondiale pour chercher des noms de lieux géographiques

OpenDataSoft : une plateforme avec plus de 1800 jeux de données en accès libre

Data France, une plateforme de visualisation de données en open data

Numbeo, une banque de données et de cartes sur les conditions de vie dans le monde

-

sur Des images satellites déclassifiées révèlent les impacts de la guerre du Vietnam

Publié: 17 December 2024, 4:12am CET

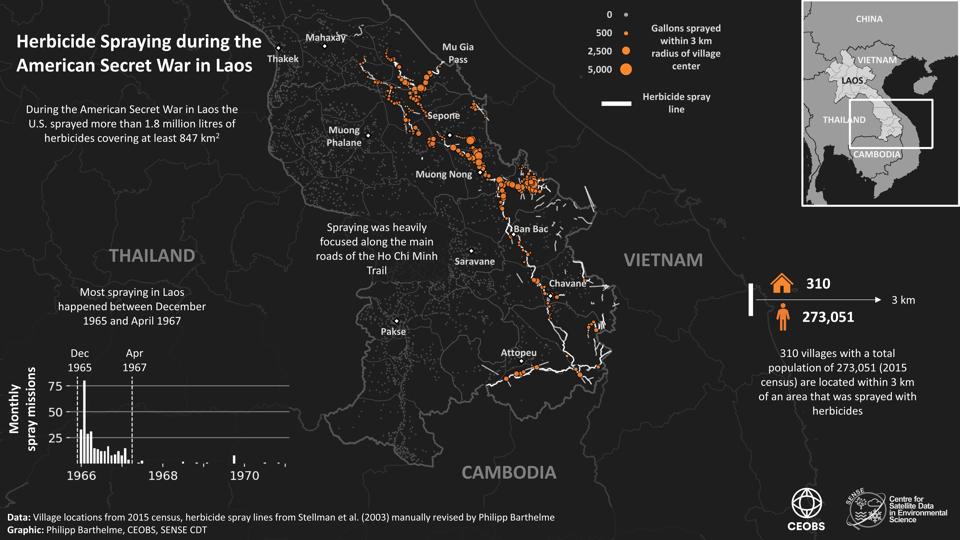

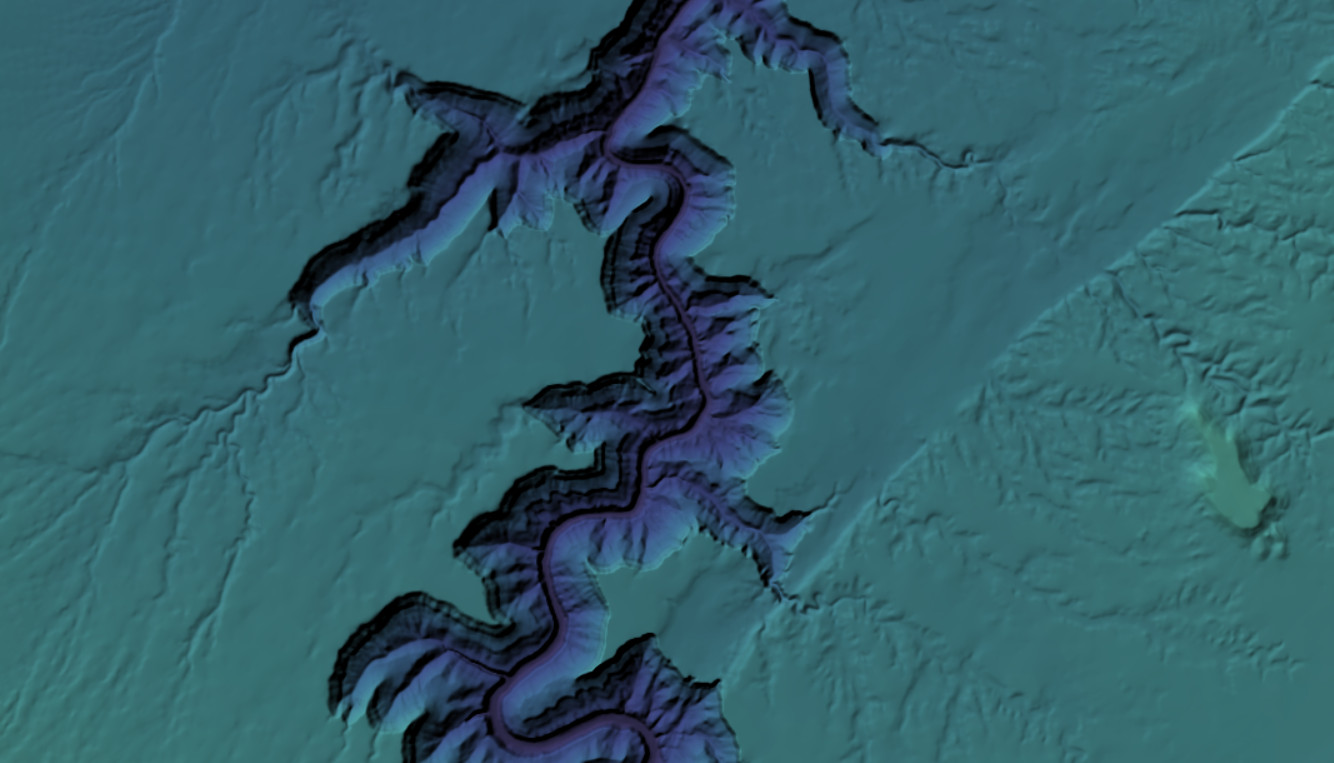

Source : « Declassified satellite photos reveal impacts of Vietnam War » (Science.org)Pendant la guerre du Vietnam, les États-Unis ont largué plus de 8 millions de tonnes de bombes et 74 millions de litres d’Agent orange ainsi que d’autres herbicides sur le Vietnam, le Cambodge et le Laos. Près de 50 ans après la fin de la guerre, les conséquences mortelles de ces campagnes militaires persistent : les munitions non explosées continuent de mutiler et de tuer, tandis que des points chauds de dioxine, une toxine puissante présente dans les herbicides, sont suceptibles de contribuer à des cancers et des malformations congénitales. Aujourd’hui, grâce à des photos satellites militaires déclassifiées, des scientifiques ont identifié les emplacements probables de ces zones à risque, ce qui pourrait aider à orienter les opérations de repérage et de nettoyage.

Il est difficile d’identifier ces zones à risque dans le paysage moderne. La végétation tenace a depuis longtemps masqué les cicatrices de la guerre, et les archives historiques sur les missions de bombardement et les épandages d’herbicides sont à la fois incomplètes et imprécises. C'est pourquoi Philipp Barthelme, étudiant diplômé en géosciences à l'Université d'Édimbourg, et ses collègues se sont tournés vers des photos satellites déclassifiées des missions KH-9 HEXAGON et KH-4a/b CORONA, qui étaient suffisamment nettes pour révéler des détails à des échelles très fines (60 cm).

Bien que les données satellite ne permettent pas à elles seules d'identifier les bombes non explosées, les chercheurs ont supposé qu'elles se trouvaient probablement dans les régions qui ont été lourdement bombardées. Les cratères des bombes explosées ressortent sur les images satellite sous forme de taches blanches brillantes. Les chercheurs ont utilisé l'apprentissage automatique, une sorte d'intelligence artificielle, pour repérer plus de 500 000 de ces cratères dans la province vietnamienne de Quang Tri, qui a été la plus bombardée pendant la guerre, ainsi que dans une région proche des frontières du Vietnam, du Laos et du Cambodge.

Les données satellite peuvent également aider à suivre l’impact des conflits modernes, explique Sergii Skakun, chercheur à l’Université du Maryland qui utilise l’imagerie satellite pour suivre la manière dont la guerre en cours en Ukraine endommage les terres agricoles et la production agricole. Skakun, qui a présenté une affiche lors de la réunion de l’AGU, a identifié plus de 3,8 millions de cratères d’artillerie dans son analyse de quelque 31 000 kilomètres carrés d’Ukraine en 2022. Les drones civils sont interdits dans la région, note Skakun, ce qui signifie que les images satellites commerciales et gouvernementales accessibles au public sont le seul moyen de surveiller les impacts en temps réel.

Sources scientifiques

Philipp Barthelme, Eoghan Darbyshire, Dominick V. Spracklen, Doug Weir, Gary R. Watmough. Combining Historical Records and Declassified U.S. Spy Satellite Imagery to Assess the Long-term Impacts of the Vietnam War (AGU24). [Combinaison de documents historiques et d'images satellites d'espionnage américain déclassifiées pour évaluer les impacts à long terme de la guerre du Vietnam]. [https:]]New data on Agent Orange use during the US’s secret war in Laos. Conflict and Environment Observatory (CEOBS) . [https:]]

Pulvérisation d’herbicides pendant la guerre secrète américaine au Laos (source : CEOBS)

Philipp Barthelme, Eoghan Darbyshire, Dominick V. Spracklen, Gary R. Watmough, Detecting Vietnam War bomb craters in declassified historical KH-9 satellite imagery, [Détection de cratères de bombes de la guerre du Vietnam dans des images satellite historiques déclassifiées du KH-9], Science of Remote Sensing, Volume 10, 2024. [https:]]Cibles de bombardement au-dessus de l'Asie du Sud-Est pendant la guerre du Vietnam (source : Barthelme et al. 2024)

Pour compléter

« Des images satellites d'espionnage déclassifiées révèlent un ancien site de bataille en Irak » (Geo).

« Des sites romains découverts sur des images déclassifiées » (Ça m'intéresse).

« Des images satellites datant de la Guerre froide permettent d'évaluer les changements environnementaux » (Sciences et Avenir).Articles connexes

Des images aériennes déclassifiées prises par des avions-espions U2 dans les années 1950 ouvrent une nouvelle fenêtre pour l'étude du Proche-Orient

Plus de 400 000 photographies aériennes mises en ligne par les archives historiques de l'Angleterre

Les ventes d'armes des Etats-Unis et de la Russie (1950-2017)

Cartes sur le débarquement en Normandie (6 juin 1944)

Cartes et données sur les conflits et violences dans le monde (ACLED)

Ukraine : comment cartographier la guerre à distance ?

Des différents modes de visualisation pour comparer des images aériennes ou satellitaires

Cartes et atlas historiques -

sur Carte du déploiement de la fibre optique en France

Publié: 16 December 2024, 8:00am CET

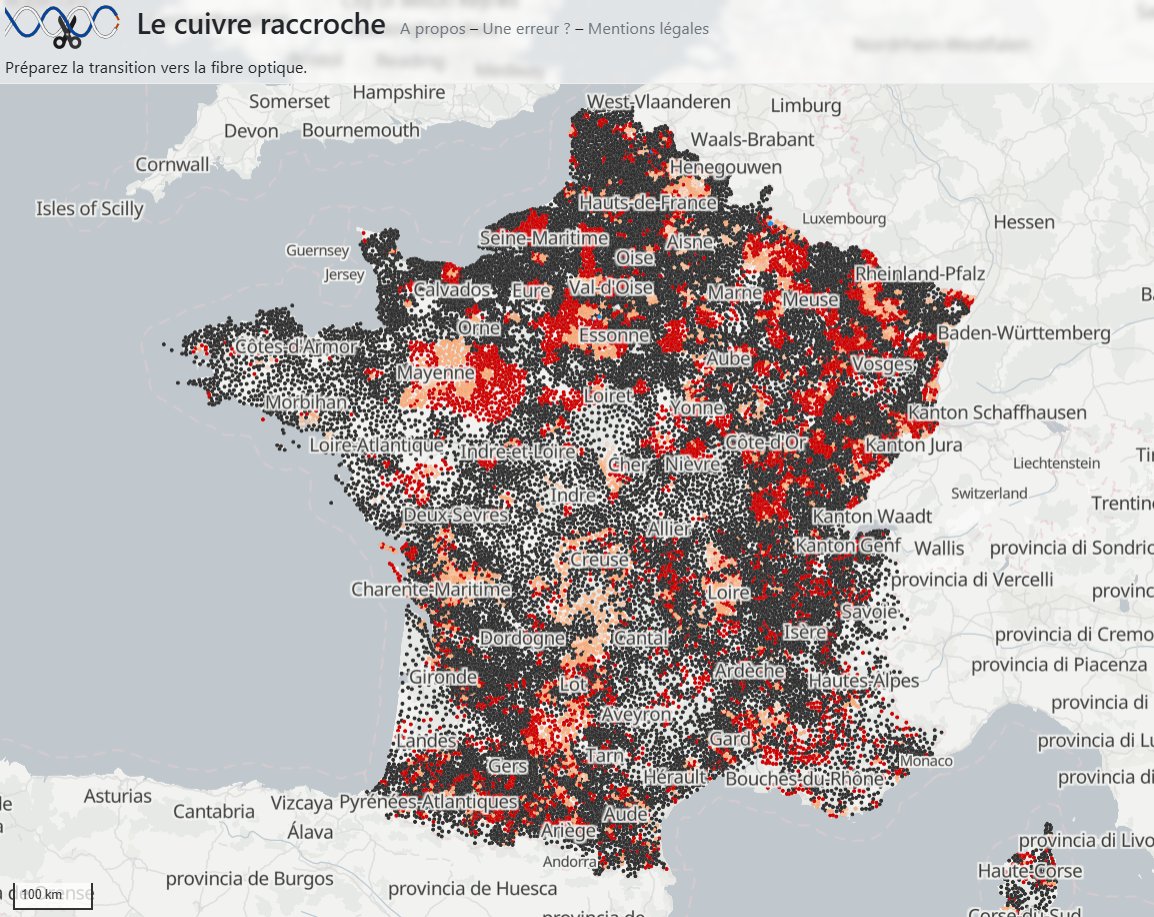

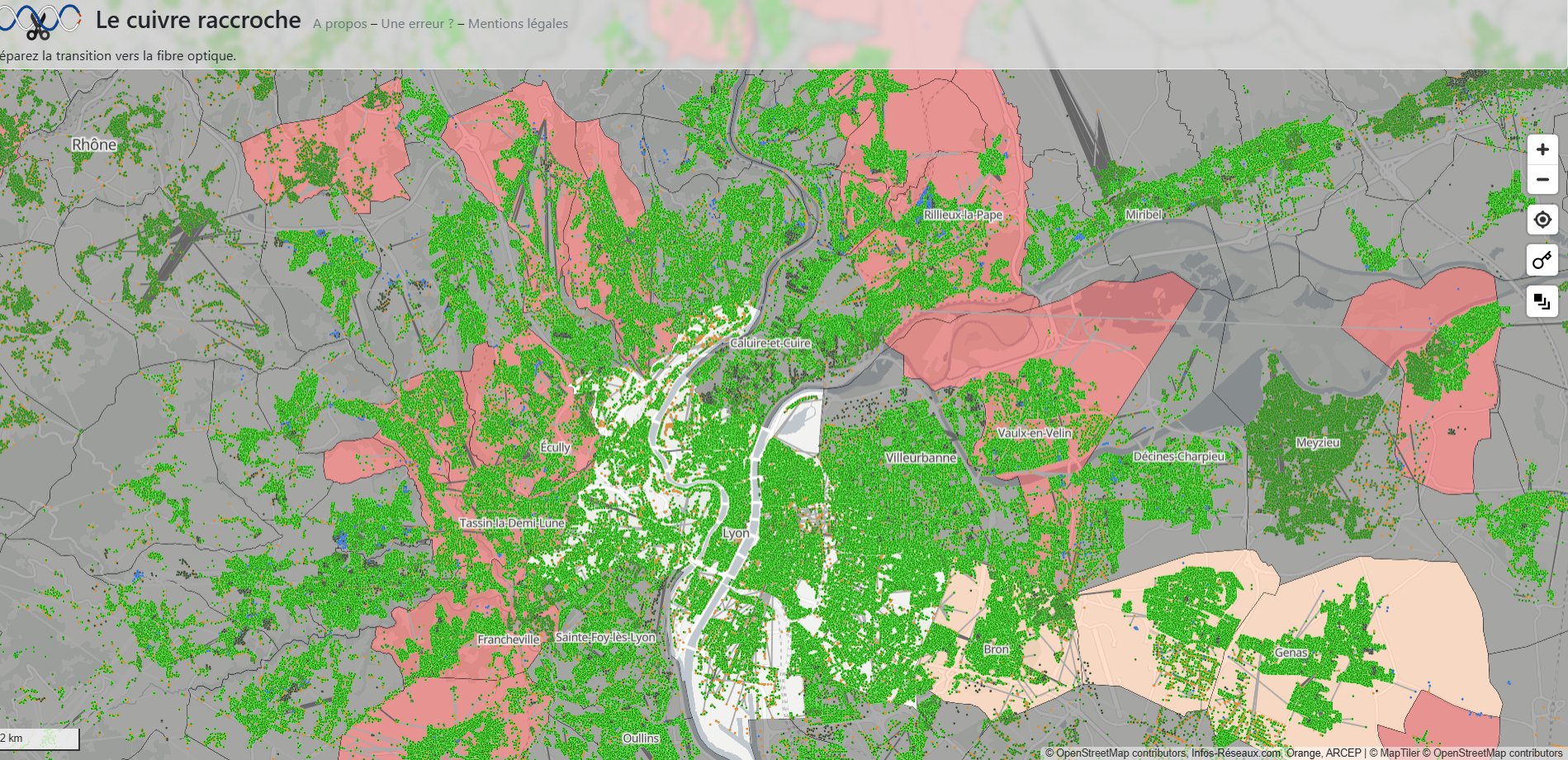

Il était jusqu'à récemment difficile de se rendre compte des disparités entre la desserte du réseau cuivre et de celle de la fibre alors que le second est appelé à remplacer le premier. Le site cuivre.infos-reseaux propose une vue cartographique du programme de fermeture du réseau cuivre et de la complétude FTTH associée dans chaque commune. Le programme se déroule selon un calendrier progressif sur 10 ans, partant d'expérimentations sur des périmètres réduits jusqu'à des phases industrielles de plusieurs millions de locaux. Il est donc particulièrement utile de disposer d'outils efficaces pour en comprendre le déroulement. Cette application prétend répondre à une partie de ces besoins.

« Le cuivre raccroche. Préparez la transition vers la fibre optique » (source : cuivre.infos-reseaux.com)

Si l'on zoome sur la carte, on voit apparaître les foyers connectés au réseau cuivre (en rose) et ceux connectés au réseau fibre (en vert). La carte permet ainsi d'analyser l'inégale couverture de la fibre optique sur le territoire national à l'échelle de chaque commune et de chaque adresse. Les territoires ultramarins sont également représentés.Etat du déploiement de la fibre optique dans la région lyonnaise (source : cuivre.infos-reseaux.com)

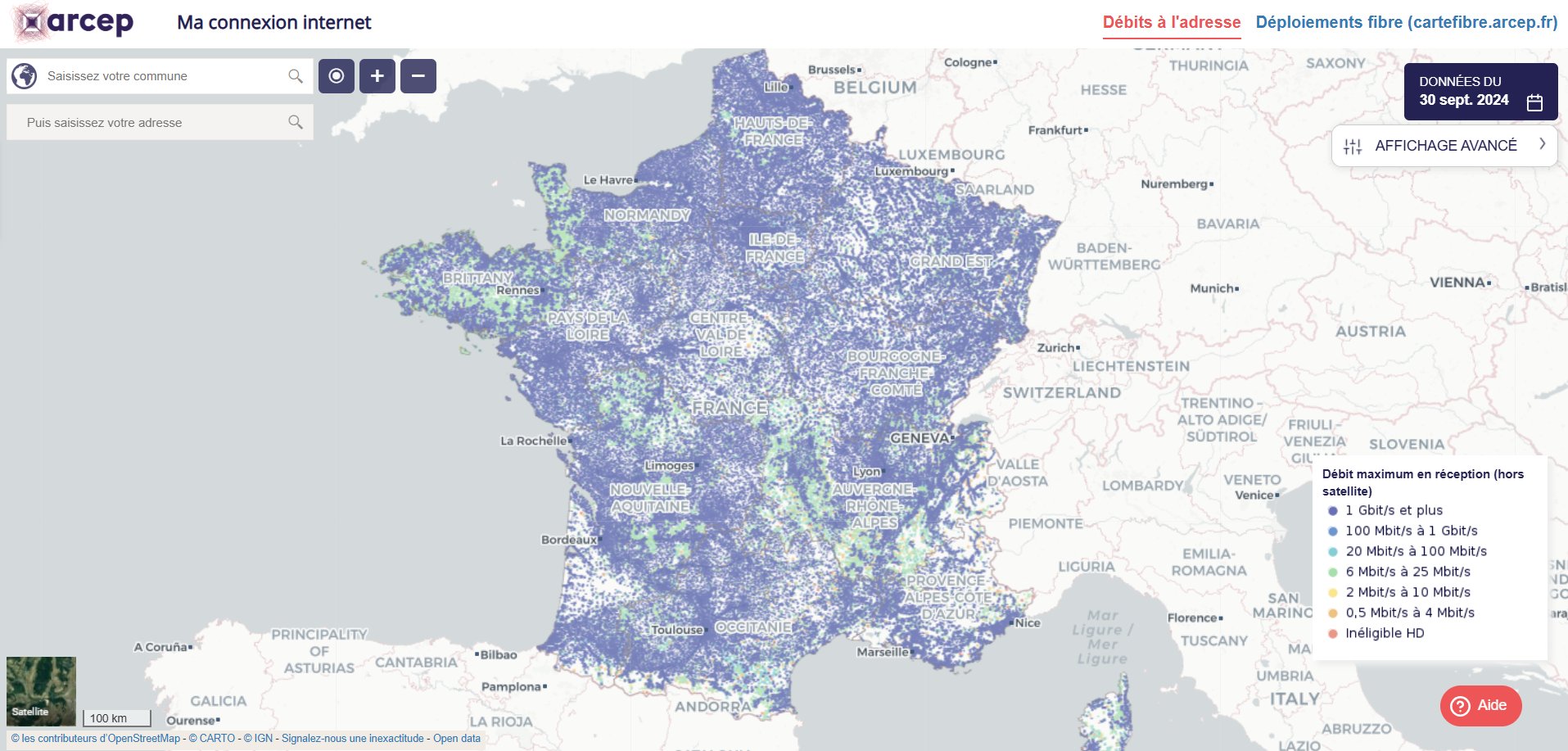

Les données très précises sont celles de l'ARCEP. L'article 28 de la décision ARCEP 2023-2802 encadre la publication des données utilisées par cette application. Cette publication ne prévoit pas la géolocalisation des adresses. Les positions ne sont donc pas données par Orange mais obtenues à partir de la BAse Adresse Nationale (BAN), dont la complétude et l'exactitude sont in fine de la responsabilité des mairies.

Les données descriptives des adresses desservies par les réseaux fibre sont publiées par l'ARCEP dans le cadre de ses études de marché du Très Haut Débit et de sa collecte de données auprès des opérateurs. Elles sont disponibles sur le site gouvernemental data.gouv.fr.

Les données relatives au programme de fermeture et les adresses desservies par le réseau cuivre sont aussi publiées par Orange France

La carte des déploiements fibre (FttH) est aussi visible sur le site de l'ARCEP. On y trouve en plus la carte des débits en réception pour chaque adresse.

Articles connexes

Carte mondiale des antennes-relais mobiles à partir des données ouvertes d'OpenCelliD

Infrastructures numériques : un accès encore inégal selon les pays

La carte mondiale de l'Internet selon Telegeography

Les câbles sous-marins, enjeu majeur de la mondialisation de l'information

Une cartographie mondiale des points de connexion Wi-Fi réalisée dans le cadre du projet WiGLE

Cartographie nationale des lieux d'inclusion numérique (ANCT - MedNum)

L'essor parallèle de la Silicon Valley et d'Internet : du territoire au réseau et inversement

La carte des tiers-lieux en France

-